Inleiding tot data science-technieken

In de wereld van vandaag waar data het nieuwe goud is, zijn er verschillende soorten analyses beschikbaar voor een bedrijf om te doen. Het resultaat van een data science-project varieert sterk met het type beschikbare gegevens en daarom is de impact ook variabel. Aangezien er veel verschillende soorten analyses beschikbaar zijn, wordt het noodzakelijk om te begrijpen welke enkele baseline-technieken moeten worden geselecteerd. Het essentiële doel van data science-technieken is niet alleen zoeken naar relevante informatie, maar ook zwakke links detecteren die ertoe neigen het model slecht te laten presteren.

Wat is Data Science?

Data science is een veld dat zich over verschillende disciplines verspreidt. Het bevat wetenschappelijke methoden, processen, algoritmen en systemen om kennis te verzamelen en eraan te werken. Dit veld bevat verschillende genres en is een gemeenschappelijk platform voor het verenigen van concepten van statistieken, gegevensanalyse en machine learning. Hierin werken de theoretische kennis van statistieken samen met realtime gegevens en technieken in machine learning hand in hand om vruchtbare resultaten voor het bedrijf te behalen. Met behulp van verschillende technieken die in de gegevenswetenschap worden gebruikt, kunnen we in de wereld van vandaag een betere besluitvorming impliceren die anders uit het oog en het verstand van de mens zou ontbreken. Vergeet niet dat de machine nooit vergeet! Om de winst in een datagestuurde wereld te maximaliseren, is de magie van Data Science een noodzakelijk hulpmiddel om te hebben.

Verschillende soorten Data Science-techniek

In de volgende paar paragrafen zouden we kijken naar gemeenschappelijke data science-technieken die in elk ander project worden gebruikt. Hoewel de data science-techniek bedrijfsspecifiek kan zijn en misschien niet in de onderstaande categorieën valt, is het prima om ze als verschillende typen te noemen. Op een hoog niveau verdelen we de technieken in Supervised (we kennen de doelimpact) en Unsupervised (we weten niet welke doelvariabele we proberen te bereiken). In het volgende niveau kunnen de technieken worden onderverdeeld in termen van

- De output die we zouden krijgen of wat de bedoeling is van het bedrijfsprobleem

- Type gebruikte gegevens.

Laten we eerst kijken naar segregatie op basis van intentie.

1. Ongecontroleerd leren

- Onregelmatigheidsdetectie

In dit type techniek identificeren we elk onverwacht voorval in de hele gegevensset. Omdat het gedrag verschilt van het feitelijk gebeuren van een data, zijn de onderliggende veronderstellingen:

- Het voorkomen van deze instanties is erg klein in aantal.

- Het verschil in gedrag is aanzienlijk.

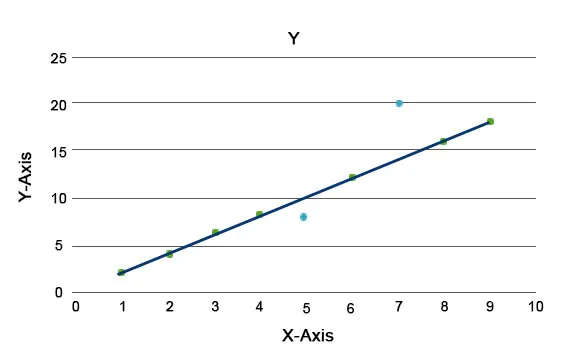

Anomalie-algoritmen worden uitgelegd, zoals het Isolation Forest, dat een score biedt voor elk record in een gegevensset. Dit algoritme is een op een boom gebaseerd model. Met behulp van dit soort detectietechnieken en de populariteit ervan worden ze gebruikt in verschillende businesscases, bijvoorbeeld webpaginabezoeken, churn rate, omzet per klik, enz. In de onderstaande grafiek kunnen we uitleggen hoe anomalie eruit ziet.

Hier vertegenwoordigen degenen in het blauw een afwijking in de gegevensset. Ze verschillen van de reguliere trendlijn en komen minder vaak voor.

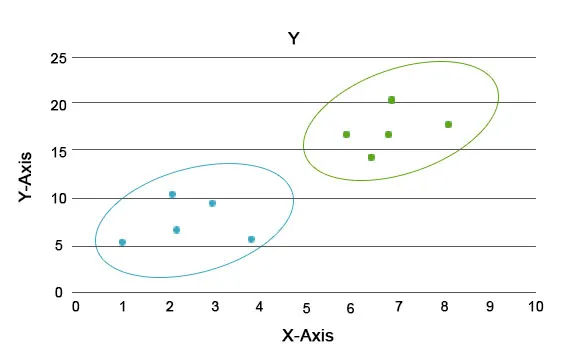

- Clustering analyse

Door deze analyse is de belangrijkste taak om de hele gegevensset in groepen te scheiden, zodat de trend of eigenschappen in de gegevens van een groep behoorlijk op elkaar lijken. In data science-terminologie noemen we deze het cluster. In de detailhandel is er bijvoorbeeld een plan om het bedrijf op te schalen en is het noodzakelijk om te weten hoe de nieuwe klanten zich zouden gedragen in een nieuwe regio op basis van de gegevens die we in het verleden hebben. Het wordt onmogelijk om een strategie te bedenken voor elk individu in een populatie, maar het zal nuttig zijn om de populatie in clusters te bundelen, zodat de strategie effectief is in een groep en schaalbaar is.

Hier zijn de blauwe en oranje kleuren verschillende clusters met unieke eigenschappen in zichzelf.

- Vereniging analyse

Deze analyse helpt ons bij het opbouwen van interessante relaties tussen items in een gegevensset. Deze analyse legt verborgen relaties bloot en helpt bij het weergeven van gegevenssetitems in de vorm van associatieregels of sets van frequente items. De associatieregel is onderverdeeld in 2 stappen:

- Frequent Itemset Generation: hierin wordt een set gegenereerd waarin vaak voorkomende items samen worden ingesteld.

- Regelgeneratie: de set die hierboven is gebouwd, wordt door verschillende lagen regelvorming gevoerd om een verborgen relatie tussen hen op te bouwen. De set kan bijvoorbeeld vallen in conceptuele of implementatieproblemen of toepassingsproblemen. Deze worden vervolgens vertakt in respectieve bomen om de associatieregels te bouwen.

APRIORI is bijvoorbeeld een algoritme voor het opbouwen van associatieregels.

2. Begeleid leren

- Regressie analyse

In regressieanalyse definiëren we de afhankelijke / doelvariabele en de resterende variabelen als onafhankelijke variabelen en veronderstellen we uiteindelijk hoe een / meer onafhankelijke variabelen de doelvariabele beïnvloeden. De regressie met één onafhankelijke variabele wordt univariate genoemd en met meer dan één staat bekend als multivariate. Laten we begrijpen dat we univariate gebruiken en vervolgens schalen voor multivariate.

Y is bijvoorbeeld de doelvariabele en x 1 is de onafhankelijke variabele. Dus, op basis van de kennis van de rechte lijn, kunnen we de vergelijking schrijven als y = mx 1 + c. Hier bepaalt "m" hoe sterk y wordt beïnvloed door x 1 . Als "m" zeer dicht bij nul ligt, betekent dit dat met een wijziging in x 1 y niet sterk wordt beïnvloed. Met een getal groter dan 1 wordt de impact sterker en leidt een kleine verandering in x 1 tot een grote variatie in y. Net als univariate, kan in multivariate worden geschreven als y = m 1 x 1 + m 2 x 2 + m 3 x 3 ………. Hier wordt de impact van elke onafhankelijke variabele bepaald door de bijbehorende “m”.

- Classificatie analyse

Net als bij clusteranalyse worden classificatie-algoritmen gebouwd met de doelvariabele in de vorm van klassen. Het verschil tussen clustering en classificatie ligt in het feit dat we bij clustering niet weten in welke groep de gegevenspunten vallen, terwijl we in classificatie weten tot welke groep ze behoren. En het verschilt van regressie vanuit het perspectief dat het aantal groepen een vast aantal moet zijn in tegenstelling tot regressie, het is continu. Er zijn een heleboel algoritmen in classificatieanalyse, bijvoorbeeld ondersteunende vectormachines, logistieke regressie, beslissingsbomen, enz.

Conclusie

Concluderend begrijpen we dat elk type analyse op zichzelf enorm is, maar hier kunnen we een kleine smaak geven aan verschillende technieken. In de volgende paar opmerkingen zouden we elk van hen afzonderlijk nemen en in detail ingaan op verschillende subtechnieken die in elke oudertechniek worden gebruikt.

Aanbevolen artikel

Dit is een gids voor Data Science Techniques. Hier bespreken we de introductie en verschillende soorten technieken in data science. U kunt ook onze andere voorgestelde artikelen doornemen voor meer informatie -

- Data Science Tools | Top 12 gereedschappen

- Data Science-algoritmen met typen

- Inleiding tot carrière in data science

- Data Science versus Data Visualization

- Voorbeelden van multivariate regressie

- Maak beslisboom met voordelen

- Kort overzicht van Data Science Lifecycle