Hoe bijenkorf te installeren?

Apache Hadoop is een verzameling van het framework waarmee big data over het cluster kunnen worden verwerkt. Volgens Apache Hive is een datawarehouse-softwareproject gebouwd bovenop Apache Hadoop voor het leveren van gegevensquery's en analyses. Apache-bijenkorf biedt een SQL-achtige interface voor het opvragen en verwerken van een grote hoeveelheid gegevens genaamd HQL (Hive-querytaal). Apache-bijenkorf draait op het Hadoop-ecosysteem en de gegevens die zijn opgeslagen in de vorm van een bestand betekent Hadoop distributed file system (HDFS). Apache Hive biedt een geweldige interface voor de gebruiker om toegang te krijgen tot en een bewerking uit te voeren op de gegevens in de vorm van een tabel. Het biedt een geweldige optimalisatietechniek om de prestaties te verbeteren. Het is heel uitdagend om de vraag sneller te maken met big data en geloof me, het is belangrijk in een productieomgeving.

In de back-end converteert de compiler de HQL-query in kaarten om taken te verminderen en vervolgens voor uitvoering in te dienen bij het Hadoop-framework.

Verschil tussen Hive en SQL

Apache Hive lijkt sterk op SQL, maar zoals we weten, draait Hive bovenop het Hadoop-ecosysteem en converteert het taken intern naar MR (Map Reduce-taken), het maakt een verschil tussen Hive en SQL.

Hive zou niet de beste aanpak zijn voor die applicaties waar een zeer snelle reactie vereist is en het is erg belangrijk om te begrijpen dat Hive beter geschikt is voor batchverwerking over zeer grote sets van onveranderlijke gegevens en we moeten opmerken dat Hive een reguliere RDBMS is en als laatste maar niet in de laatste plaats is Apache Hive een schema op leesmiddelen (bij het invoegen van gegevens in de Hive-tabel maakt het zich geen zorgen over mismatch van het gegevenstype, maar tijdens het lezen van gegevens zal het een nulwaarde tonen als het gegevenstype niet overeenkomt met het gegevenstype van de specifieke kolom).

Voorafgaande vereiste om Hive te installeren

Zoals ik al eerder zei, is het erg belangrijk om te begrijpen dat Apache-bijenkorven bovenop Hadoop Ecosystem en Hadoop bij alle demonen aan de gang moeten zijn.

Enkele van de basis Hadoop-demonen zijn als volgt:

- Naam knooppunt

- Dataknooppunt

- Bronbeheer

- Knooppuntbeheerder

Om de Hadoop-versie hieronder te controleren, is het commando:

Typ → Hadoop-versie in de opdrachtprompt, deze geeft u de versie van Hadoop.

Ga als volgt te werk om de Hadoop-clusterrapport trigger hieronder te controleren:

Typ → Hadoop dfsadmin –report in de opdrachtprompt en geeft u het hele clusterverslag als uw server actief is.

Als Hadoop niet op uw machine is geïnstalleerd en u wordt gevraagd om de apache-instructies te volgen, moet u Hadoop op uw systeem installeren.

Ik hoop dat Java ook al op je systeem is geïnstalleerd. kijk hieronder om de javaversie te bekijken.

Stappen om Hive op Ubuntu te installeren

Hieronder zijn de stappen om Hive op Ubuntu te installeren als volgt:

Stap 1 : Hive tar die we kunnen downloaden met behulp van onderstaande opdracht in de terminal kunnen we ook rechtstreeks downloaden van de terminal.

Commando: we krijgen http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Stap 2 : Pak het tar- bestand uit met behulp van het onderstaande commando in de terminal. We kunnen het tar boven het gedownloade tar hive tar-bestand direct extraheren.

Commando: tar -xzf apache-hive-2.1.0-bin.tar.gz

Ik zal je aanraden om te verifiëren met het commando ls over het uitgepakte bestand.

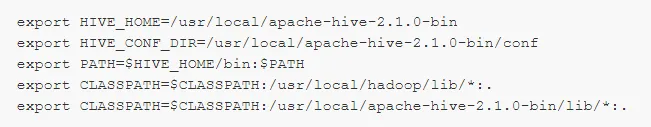

Stap 3: Bewerk het " .bashrc " -bestand om de omgevingsvariabelen voor de gebruiker bij te werken.

Commando: sudo de .bashrc

Voeg het volgende toe aan het einde van het bestand:

# Stel HIVE_HOME in

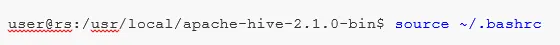

Voer de onderstaande opdracht uit om de wijzigingen in de huidige terminal te voltooien.

Commando: bron .bashrc

Stap 5 : We moeten Hive-mappen maken binnen de HDFS-locatie en dit 'magazijn' in de map is de locatie waar de metadata-gerelateerde informatie van de Hive-tabel en gegevens met betrekking tot Hive worden opgeslagen.

Commando :

- hdfs dfs -mkdir -p / user / hive / magazijn

- hdfs dfs -mkdir / tmp

Stap 6 : Voer de onderstaande opdracht uit om de lees- en schrijfmachtiging voor de component in te stellen.

Commando:

In onderstaande opdracht, schrijfrechten geven aan de gebruikersgroep:

- hdfs dfs -chmod g + w / user / hive / warehouse

- hdfs dfs -chmod g + w / tmp

Hive configureren: Het is heel belangrijk om Hive te configureren met Hadoop. We moeten hive-env.sh bewerken, een bestand dat in de map $ HIVE_HOME / conf wordt geplaatst. De volgende opdrachten worden omgeleid naar de map Hive conf en kopiëren het sjabloonbestand:

Stap 7 : Stel een Hadoop- pad in hive-env.sh in

Bewerk het bestand hive-env.sh door de volgende regel toe te voegen:

Door dit proces zijn we nu bijna klaar en de bijenkorfinstallaties zijn met succes voltooid. Het is belangrijk om Metastore te configureren met de externe databaseserver en standaard gebruikt Apache Hive-framework de Derby-database. Met behulp van onderstaande opdracht Initializing Derby database.

Commando: bin / schematool -initSchema -dbType derby

Stap 8 : Start Hive .

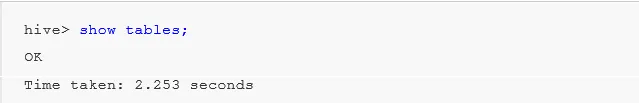

Command: hive (typ hive in de terminal binnen de tweede component van de component zal openen.)

Werken met Hive: Nu zien we enkele van de bewerkingen in de component om te zien hoeveel tabellen we in de standaarddatabase gebruiken, verwijzen naar onderstaande screenshots in de onderstaande screenshots. Er worden geen tabellen weergegeven. We hebben geen tabellen in de standaarddatabase .

Om een tabel in de component te maken, is het erg belangrijk om naar de vereiste database te verwijzen, anders wordt elke tabel gemaakt in de standaarddatabase.

Belangrijke opdrachten in Hive

1: toon databases (het toont alle databases die tot nu toe zijn aangemaakt).

2: maak de database aan als deze niet bestaat mydb (met deze opdracht wordt één database gemaakt met de naam ' mydb' als ' mydb' niet bestaat en als ' mydb al bestaat, geeft dit ook geen fouten')

3: gebruik de database wanneer we een DDl-commando op de specifieke database moeten gebruiken, we moeten het commando "database gebruiken" gebruiken in ons geval dat we al een "mydb" showcommando hebben gemaakt, zou mydb worden gebruikt .

Belangrijk Hive DDL-commando

MAKEN, DALEN, TRUNCEREN, TONEN, BESCHRIJVEN .

- Maken : - Maak een statement dat wordt gebruikt om een database te maken of een tabel in component.

Voorbeeld: bijenkorf> database maken Bedrijf; (database aanmaken)

Hive> gebruik Bedrijf;

Hive> maak tabel medewerker (id int, naam String, salaris String); (hierdoor wordt een tabelmedewerker onder Database Company gemaakt, omdat we de opdracht Database gebruiken al hebben uitgevoerd.)

- Beschrijven biedt informatie over het schema van de tabel.

Bijenkorf> werknemer beschrijven; (dit geeft de schemadetails van de medewerkerstabel in detail)

- TRUNCATE verwijdert de gegevens van de tabel.

Hive> truncate tafel medewerker;

We kunnen de Hive ook in een venster installeren, maar voor de beste praktijk geef ik de voorkeur aan Ubuntu, het geeft een beter beeld van de productieomgeving en uw gegevens zullen in de toekomst toenemen en het is gemakkelijk te beheren.

Aanbevolen artikelen

Dit is een handleiding voor Hive installeren. Hier hebben we de verschillende stappen besproken om Hive, DDL-opdracht enz. Te installeren. U kunt ook de volgende artikelen bekijken voor meer informatie:

- Hoe SQL Server te installeren

- Hoe MATLAB te installeren

- Bijenkorfopdrachten en functie

- Sollicitatievragen voor Basic Hive

- Bijenkorf architectuur WorkFlow

- ORDER BY-functie gebruiken in Hive

- Bijenkorfinstallatie