Inleiding tot kernelmethoden in machinaal leren

Het algoritme dat wordt gebruikt voor patroonanalyse wordt de kernelmethode genoemd in Machine Learning. In het algemeen wordt er een analyse gedaan om relaties in datasets te vinden. Deze relaties kunnen clustering, classificatie, hoofdcomponenten, correlatie, enz. Zijn. De meeste van deze algoritmen die deze taken van het analyseren van het patroon oplossen, moeten de gegevens in ruwe representatie hebben, moeten expliciet worden omgezet in een kenmerkvectorrepresentatie. Deze transformatie kan worden uitgevoerd via een door de gebruiker opgegeven functiekaart. Dus kan worden aangenomen dat alleen de door de gebruiker opgegeven kernel vereist is voor de kernelmethode.

De terminologie Kernal Method komt van het feit dat ze de kernelfunctie gebruiken, waarmee ze de bewerking kunnen uitvoeren in hoog-dimensionale, impliciete functieruimte zonder de coördinaten van de gegevens in die ruimte te hoeven berekenen. In plaats daarvan berekenen ze eenvoudig het interne product tussen de afbeeldingen van alle gegevensparen in de objectruimte.

Dit soort bewerkingen zijn meestal goedkoper dan de expliciete berekening van de coördinaten. Deze techniek wordt 'kerneltruc' genoemd. Elk lineair model kan worden omgezet in een niet-lineair model door de kerneltruc op het model toe te passen.

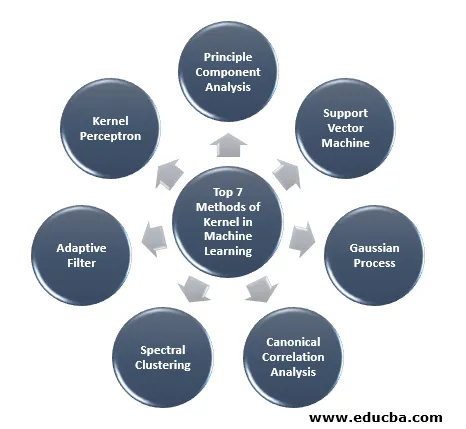

De kernelmethode die beschikbaar is in machine learning is de analyse van de belangrijkste componenten (PCA), spectrale clustering, ondersteuning van vectormachines (SVM), canonieke correlatieanalyse, kernel perceptron, Gauss-processen, nokregressie, lineaire adaptieve filters en vele anderen. Laten we een goed begrip hebben van enkele van deze kernelmethoden.

Top 7 methoden van kernel in machinaal leren

Hier zijn de onderstaande methoden voor kernel in machinaal leren:

1. Principe componentenanalyse

Principal component analysis (PCA) is een techniek voor het extraheren van structuur uit mogelijk hoogdimensionale gegevenssets. Het wordt gemakkelijk uitgevoerd door iteratieve algoritmen te gebruiken die hoofdcomponenten schatten of door een eigenwaardeprobleem op te lossen. PCA is een orthogonale transformatie van het coördinatensysteem waarin we onze gegevens beschrijven. Het nieuwe coördinatensysteem wordt verkregen door projectie op de hoofdassen van de gegevens. Een klein aantal hoofdcomponenten is vaak voldoende om het grootste deel van de structuur in de gegevens te verklaren. Een van de belangrijkste toepassingen is het uitvoeren van verkennende gegevensanalyse voor het maken van een voorspellend model. Het werd meestal gebruikt om de verwantschap tussen populaties en genetische afstand zichtbaar te maken.

2. Ondersteuning Vector Machine

SVM kan worden gedefinieerd als een classificator voor het scheiden van hypervlak waarbij hypervlak de subruimte is van één dimensie minder dan de omgevingsruimte. De dimensie van deze wiskundige ruimte wordt gedefinieerd als het minimum aantal coördinaten dat vereist is om een willekeurig punt op te geven, terwijl de omgevingsruimte de ruimte is die het wiskundige object omgeeft. Nu kan een wiskundig object worden opgevat als een abstract object dat op geen enkel moment of op elke plaats bestaat, maar bestaat als een soort ding.

3. Gaussiaans proces

Het Gaussiaanse proces is vernoemd naar Cark Friedrich Gauss omdat het de notatie van Gaussiaanse distributie gebruikt (normale distributie). Het is een stochastisch proces dat een verzameling willekeurige variabelen betekent geïndexeerd door tijd of ruimte. In Gaussiaans proces hebben willekeurige variabelen een multivariate normale verdeling, dat wil zeggen dat alle eindige lineaire combinaties ervan normaal verdeeld zijn. Het Gaussiaanse proces gebruikt de eigenschappen die zijn geërfd van een normale verdeling en zijn daarom nuttig bij statistische modellering. Machine Learning-algoritme waarbij deze kernelmethode wordt gebruikt, gebruikt de maat van lui leren en de overeenkomst tussen punten om de waarde van ongeziene punten uit trainingsgegevens te voorspellen. Deze voorspelling is niet alleen de schatting, maar ook de onzekerheid op dat moment.

4. Canonieke correlatieanalyse

Canonieke correlatieanalyse is een manier om informatie af te leiden uit cross-covariantiematrices. Het is ook bekend als canonieke variabelenanalyse. Stel dat we twee vector X, Y van willekeurige variabele hebben, zeg twee vectoren X = (X1, …, Xn) en vector Y = (Y1, …, Ym), en de variabele met correlatie, dan zal CCA een lineaire combinatie van X berekenen en Y die de maximale correlatie onder elkaar heeft.

5. Spectrale clustering

Bij de toepassing van beeldsegmentatie staat spectrale clustering bekend als op segmenten gebaseerde objectcategorisatie. In Spectrale Clustering wordt dimensionaliteitsreductie uitgevoerd vóór clustering in minder dimensie, dit wordt gedaan met behulp van de eigenwaarde van de overeenkomstenmatrix van de gegevens. Het heeft zijn wortels in de grafentheorie, waar deze benadering wordt gebruikt om gemeenschappen van knooppunten in een grafiek te identificeren die is gebaseerd op de randen die hen verbinden. Deze methode is flexibel genoeg en stelt ons in staat om ook gegevens uit niet-grafieken te clusteren.

6. Adaptief filter

Het adaptieve filter gebruikt een lineair filter dat een overdrachtsfunctie omvat, die wordt bestuurd door variabele parameters en de methoden, die zullen worden gebruikt om deze parameters aan te passen volgens het optimalisatie-algoritme. De complexiteit van dit optimalisatie-algoritme is de reden dat alle adaptieve filters een digitaal filter zijn. Een adaptief filter is nodig in die toepassingen waar er geen voorafgaande informatie is over de gewenste verwerkingsoperatie of die veranderen.

De kostenfunctie wordt gebruikt in het adaptieve filter met gesloten lus, omdat dit noodzakelijk is voor de optimale prestaties van het filter. Het bepaalt hoe de filteroverdrachtsfunctie moet worden gewijzigd om de kosten van de volgende iteratie te verlagen. Een van de meest voorkomende functies is de gemiddelde kwadratische fout van het foutsignaal.

7. Kernel Perceptron

In machine learning is de kernel perceptron een type van het populaire perceptron leeralgoritme dat kernelmachines kan leren, zoals niet-lineaire classificatoren die een kernelfunctie gebruiken om de gelijkenis te berekenen van die monsters die onzichtbaar zijn voor trainingsmonsters. Dit algoritme is uitgevonden in 1964 en is daarmee de eerste leerling van de kernelclassificatie.

De meeste van de besproken kernelalgoritmen zijn gebaseerd op convexe optimalisatie of eigenproblemen en zijn statistisch goed onderbouwd. Hun statistische eigenschappen worden geanalyseerd met behulp van de statistische leertheorie.

Over de toepassingsgebieden van kernelmethoden gesproken, het is divers en omvat geostatistiek, kriging, inverse afstandsweging, 3D-reconstructie, bio-informatica, chemo-informatica, informatie-extractie en handschriftherkenning.

Conclusie

Ik heb enkele van de terminologieën en soorten kernelmethoden in Machine Learning samengevat. Vanwege ruimtegebrek is dit artikel geenszins uitgebreid en is het alleen bedoeld om u een idee te geven van wat de kernelmethode is en een korte samenvatting van hun typen. Als u dit artikel behandelt, zult u echter de eerste stap zetten op het gebied van Machine Learning.

Aanbevolen artikelen

Dit is een handleiding voor de kernelmethode in machinaal leren. Hier bespreken we de 7 soorten kernelmethoden in Machine Learning. U kunt ook het volgende artikel bekijken.

- Monolithische kernel

- Clustering in machine learning

- Data Science Machine Learning

- Machinaal leren zonder toezicht

- PHP-filters | Hoe gebruikersinvoer valideren met behulp van verschillende filters?

- Volledige gids voor de levenscyclus van machine learning