Introducties van Data Science Algorithms

Een beschrijving op hoog niveau van de essentiële algoritmen die worden gebruikt in Data Science. Zoals u al weet, is gegevenswetenschap een vakgebied waar beslissingen worden genomen op basis van de inzichten die we uit de gegevens halen in plaats van klassieke, op regels gebaseerde deterministische benaderingen. Meestal kunnen we een taak voor machine learning in drie delen verdelen

- Het verkrijgen van de gegevens en het in kaart brengen van het bedrijfsprobleem,

- Technieken voor machinaal leren toepassen en de prestatiemetriek observeren

- Het model testen en inzetten

In deze hele levenscyclus gebruiken we verschillende data science-algoritmen om de taak op te lossen. In dit artikel zullen we de meest gebruikte algoritmen verdelen op basis van hun leertypen en zullen we daarover op hoog niveau discussiëren.

Soorten data science-algoritmen

Op basis van de leermethoden kunnen we eenvoudigweg machine learning of data science-algoritmen onderverdelen in de volgende typen

- Algoritmen onder toezicht

- Algoritmen zonder toezicht

1. Bewaakte algoritmen

Zoals de naam suggereert, zijn bewaakte algoritmen een klasse van machine learning-algoritmen waarbij het model wordt getraind met de gelabelde gegevens. Op basis van de historische gegevens wilt u bijvoorbeeld voorspellen dat een klant een lening niet zal betalen. Na preprocess en feature engineering van de gelabelde gegevens, worden bewaakte algoritmen getraind over de gestructureerde gegevens en getest op een nieuw gegevenspunt of in dit geval om een wanbetaler te voorspellen. Laten we de meest populaire bewaakte algoritmen voor machinaal leren onder ogen zien.

- K Dichtstbijzijnde buren

K dichtstbijzijnde buren (KNN) is een van de eenvoudigste maar krachtige algoritmen voor machine learning. Het is een bewaakt algoritme waarbij de classificatie wordt gedaan op basis van de dichtstbijzijnde gegevenspunten. Het idee achter KNN is dat vergelijkbare punten worden geclusterd, door de eigenschappen van dichtstbijzijnde gegevenspunten te meten, kunnen we een testgegevenspunt classificeren. We lossen bijvoorbeeld een standaard classificatieprobleem op waarbij we willen voorspellen dat een gegevenspunt tot klasse A of klasse B behoort. Laat k = 3, nu testen we 3 dichtstbijzijnde datapunt van het testgegevenspunt, als twee van hen tot klasse behoren A zullen we het testgegevenspunt verklaren als klasse A, anders klasse B. De juiste waarde van K wordt gevonden door middel van kruisvalidatie. Het heeft een lineaire tijdcomplexiteit en kan daarom niet worden gebruikt voor toepassingen met lage latentie.

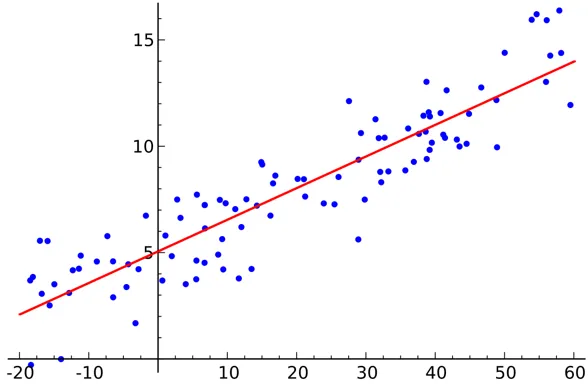

- Lineaire regressie

Lineaire regressie is een bewaakt algoritme voor data science.

Output:

Variabel is continu. Het idee is om een hyperplane te vinden waarbij het maximale aantal punten in het hyperplane ligt. Het voorspellen van de hoeveelheid regen is bijvoorbeeld een standaard regressieprobleem waarbij lineaire regressie kan worden gebruikt. Lineaire regressie veronderstelt dat de relatie tussen de onafhankelijke en afhankelijke variabelen lineair is en dat er weinig of geen multicollineariteit is.

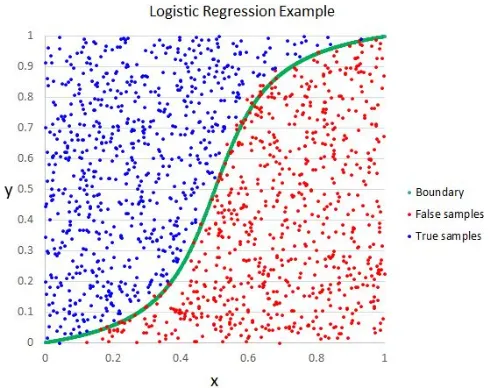

- Logistieke regressie

Hoewel de naam regressie zegt, is logistieke regressie een onder toezicht staand classificatie-algoritme.

Output:

De geometrische intuïtie is dat we verschillende klassenlabels kunnen scheiden met behulp van een lineaire beslissingsgrens. De uitvoervariabele van logistieke regressie is categorisch. Houd er rekening mee dat we geen gemiddelde kwadratische fout kunnen gebruiken als kostenfunctie voor logistieke regressie, omdat het niet-convex is voor logistieke regressie.

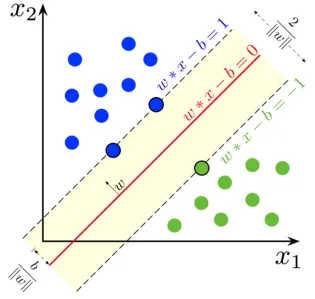

- Ondersteuning Vector Machine

Bij logistieke regressie was ons belangrijkste motto om een scheidend lineair oppervlak te vinden.

Output:

We kunnen de support-vectormachine beschouwen als een uitbreiding van dit idee, waarbij we een hyperplane moeten vinden die de marge maximaliseert. Maar wat is een marge? Voor een vector W (het beslissingsoppervlak dat we moeten bedenken), tekenen we twee parallelle lijnen aan beide zijden. De afstand tussen deze twee lijnen wordt de marge genoemd. SVM neemt aan dat de gegevens lineair kunnen worden gescheiden. Hoewel we SVM kunnen gebruiken voor niet-lineaire gegevens, kunnen we ook de kerneltruc gebruiken.

- Beslissingsboom

Decision Tree is een geneste op If-Else gebaseerde classifier die een boomachtige grafiekstructuur gebruikt om de beslissing te nemen. Beslisbomen zijn erg populair en een van de meest gebruikte bewaakte machine learning algoritmen op het hele gebied van data science. Het biedt in de meeste gevallen een betere stabiliteit en nauwkeurigheid dan andere bewaakte algoritmen en robuust voor uitbijters. De outputvariabele van de beslissingsboom is meestal categorisch, maar kan ook worden gebruikt om regressieproblemen op te lossen.

- Ensembles

Ensembles zijn een populaire categorie data science-algoritmen waarbij meerdere modellen samen worden gebruikt om betere prestaties te krijgen. Als u bekend bent met Kaggle (een platform van Google om te oefenen en te concurreren in data science-uitdagingen), zult u merken dat de meeste winnaaroplossingen een soort ensembles gebruiken.

We kunnen ensembles grofweg in de volgende categorieën verdelen

- bagging

- stimuleren

- stapelen

- Cascading

Random Forest, Gradient Boosting Decision Trees zijn voorbeelden van enkele populaire ensemble-algoritmen.

2. Niet-bewaakte algoritmen

Niet-bewaakte algoritmen worden gebruikt voor de taken waarbij de gegevens niet worden geëtiketteerd. Het meest populaire gebruik van niet-gecontroleerde algoritmen is clustering. Clustering is de taak om vergelijkbare datapunten te groeperen zonder handmatige tussenkomst. Laten we hier enkele van de populaire niet-begeleide algoritmen voor machine learning bespreken

- K Middelen

K Means is een gerandomiseerd, niet-gecontroleerd algoritme dat wordt gebruikt voor clustering. K Means volgt de onderstaande stappen

1. Initialiseer K-punten willekeurig (c1, c2..ck)

2. Voor elk punt (Xi) in de gegevensset

Selecteer de dichtstbijzijnde Ci (i = 1, 2, 3..k)

Voeg Xi toe aan Ci

3. Bereken de centroid met behulp van de juiste metrieken (dwz intracluster afstand)

4, herhaal stap (2) (3) tot het convergeert

- K betekent ++

De initialisatiestap in K betekent puur willekeurig en op basis van de initialisatie verandert de clustering drastisch. K betekent ++ lost dit probleem op door k op een probabilistische manier te initialiseren in plaats van pure randomisatie. K betekent ++ is stabieler dan klassieke K betekent.

- K Medoids:

K medoids is ook een clusteringalgoritme op basis van K-middelen. Het belangrijkste verschil tussen de twee is dat de centroïden van K middelen niet noodzakelijkerwijs in de gegevensverzameling voorkomen, wat niet het geval is voor K medoiden. K medoiden bieden een betere interpreteerbaarheid van clusters. K betekent minimaliseert de totale kwadratische fout, terwijl K medoids de ongelijkheid tussen punten minimaliseren.

Conclusie

In dit artikel hebben we de meest populaire machine learning-algoritmen besproken die op het gebied van data science worden gebruikt. Na dit alles kan de vraag opkomen dat ' welk algoritme het beste is? ' Er is duidelijk geen winnaar hier. Het hangt alleen af van de taak die moet worden uitgevoerd en van de zakelijke vereisten. Een best practice begint altijd met het eenvoudigste algoritme en verhoogt de complexiteit geleidelijk.

Aanbevolen artikelen

Dit is een gids voor Data Science Algorithms. Hier hebben we een overzicht besproken van data science-algoritmen en twee soorten data science-algoritmen. U kunt ook door onze gegeven artikelen gaan voor meer informatie-

- Data Science Platform

- Data Science-talen

- Classificatie-algoritmen

- Datamining-algoritmen

- Meest gebruikte technieken van ensemble leren

- Eenvoudige manieren om beslisboom te maken

- Complete gids voor Data Science Lifecycle