Verschil tussen Kleine gegevens en grote gegevens

Kleine gegevens, is niets anders dan de gegevens die klein genoeg zijn om in een volume en ook voor het formatteren van mensen beschikbaar te maken, waardoor ze toegankelijk, informatief en bruikbaar zijn. De traditionele gegevensverwerking kan geen grote of complexe gegevens verwerken, deze gegevens worden Big Data genoemd. Wanneer het datavolume een bepaalde limiet overschrijdt, zijn traditionele systemen en methoden niet voldoende om gegevens te verwerken of gegevens om te zetten in een nuttig formaat. Dit is de reden waarom gegevens over het algemeen in twee categorieën zijn onderverdeeld: kleine gegevens versus grote gegevens

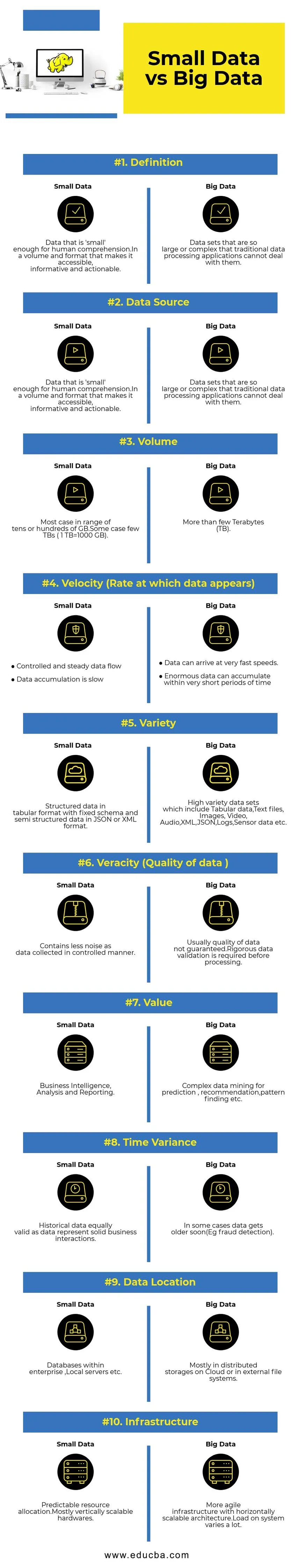

Vergelijking tussen kleine gegevens en grote gegevens (Infographics)

Hieronder staat de top 10 Verschil tussen Small Data en Big Data

Belangrijkste verschillen tussen kleine gegevens en grote gegevens

- Gegevensverzameling - Meestal maakt kleine gegevens deel uit van OLTP-systemen en wordt deze op een meer gecontroleerde manier verzameld en vervolgens in de cachelaag of database ingevoegd. Databases hebben gelezen replica's ter ondersteuning van onmiddellijke analysequery's indien nodig. Pijplijn Big Data-verzameling bevat wachtrijen zoals AWS Kinesis of Google Pub / Sub om gegevens met hoge snelheid in balans te houden. Downstream zal streaming pijpleidingen hebben voor realtime analyse en batchopdrachten voor koude gegevensverwerking.

- Gegevensverwerking - Zoals de meeste kleine gegevens die via het transactiesysteem worden gegenereerd, zijn analyses bovendien meestal batch-georiënteerd. In sommige zeldzame gevallen worden analysequery's rechtstreeks op transactiesystemen uitgevoerd. Big Data-omgevingen hebben zowel batch- als stroomverwerkingspijplijnen. Een stream wordt gebruikt voor realtime analyses zoals creditcardfraude detectie of voorspelling van de aandelenkoers. Batchverwerking gebruikt voor het implementeren van complexe bedrijfslogica met gegevens en geavanceerde algoritmen.

- Schaalbaarheid - Small Data-systemen worden doorgaans verticaal geschaald. Verticaal schalen vergroot de systeemcapaciteit door meer bronnen aan dezelfde machine toe te voegen. Verticale schaling is duur maar minder complex om te beheren. Big Data-systemen zijn meestal afhankelijk van horizontaal schaalbare architectuur die meer flexibiliteit biedt tegen lagere kosten. Pre-emptive virtuele machines beschikbaar in de cloud maken horizontaal schaalbare systemen nog betaalbaarder.

- Gegevensmodellering - Kleine gegevens die worden gegenereerd uit transactiesystemen zullen in genormaliseerde vorm zijn. ETL-gegevenspijplijnen (Extract Transform Load) zetten deze om in ster- of sneeuwvlokschema in een gegevensmagazijn. Hier wordt het schema altijd afgedwongen tijdens het schrijven van gegevens, wat relatief eenvoudig is naarmate gegevens meer gestructureerd zijn. Zoals hierboven vermeld, is tabelgegevens slechts een fractie van Big Data. Hier worden gegevens veel meer gerepliceerd om verschillende redenen, zoals het overdragen van fouten of vanwege een beperking van de onderliggende database-engine (sommige databases ondersteunen bijvoorbeeld slechts één secundaire index per gegevensset). Een schema wordt niet afgedwongen tijdens het schrijven. In plaats daarvan wordt een schema gevalideerd tijdens het lezen van gegevens.

- Opslag- en berekeningskoppeling - In traditionele databases die meestal met kleine gegevens omgaan, zijn opslag en computergebruik nauw gekoppeld. Plaatsen en ophalen van gegevens van en naar de database is alleen mogelijk via de gegeven interface. Gegevens kunnen niet rechtstreeks in het databasebestandssysteem worden geplaatst of bestaande gegevens kunnen niet worden opgevraagd met behulp van andere DB-engines. Eigenlijk helpt deze architectuur enorm om de data-integriteit te waarborgen. Big Data-systemen hebben een zeer losse koppeling tussen opslag en computers. Gewoonlijk worden gegevens opgeslagen in een gedistribueerd gegevensopslagsysteem zoals HDFS, AWS S3 of Google GCS en berekenen ze de engine om gegevens op te vragen of ETL te selecteren op een later tijdstip. Interactieve query's kunnen bijvoorbeeld worden uitgevoerd met Presto (Link) en ETL met Apache Hive op dezelfde gegevens.

- Data Science - Algoritmen voor machinaal leren vereisen invoergegevens in een goed gestructureerd en correct gecodeerd formaat, en meestal zullen invoergegevens afkomstig zijn van beide transactionele systemen zoals een datawarehouse en Big Data-opslag zoals een datameer. Machine learning-algoritmen die uitsluitend op Small Data draaien, zijn eenvoudig omdat de voorbereidingsfase van de gegevens smal is. Gegevens voorbereiden en verrijken in de Big Data-omgeving kost veel meer tijd. Big Data biedt veel opties voor data science-experimenten vanwege het grote volume en de verscheidenheid aan data.

- Gegevensbeveiliging - Beveiligingspraktijken voor kleine gegevens die zich bevinden in enterprise datawarehouse of transactiesystemen die worden geleverd door overeenkomstige databaseproviders, zoals gebruikersrechten, gegevenscodering, hashing, enz. Het beveiligen van Big Data-systemen is veel gecompliceerder en uitdagender. Best practices voor beveiliging zijn onder meer het coderen van gegevens in rust en doorvoer, het isoleren van het clusternetwerk, sterke regels voor toegangscontrole, etc.

Vergelijkingstabel kleine gegevens versus grote gegevens

| Vergelijkingsbasis | Kleine gegevens | Big Data |

| Definitie | Gegevens die 'klein' genoeg zijn voor menselijk begrip. In een volume en formaat dat het toegankelijk, informatief en bruikbaar maakt | Gegevenssets die zo groot of complex zijn dat traditionele toepassingen voor gegevensverwerking er niet mee kunnen omgaan |

| Databron | ● Gegevens van traditionele bedrijfssystemen zoals ○ Enterprise resource planning ○ Klantrelatiebeheer (CRM) ● Financiële gegevens zoals grootboekgegevens ● Betalingsgegevens van de website | ● Koop gegevens van het verkooppunt ● Clickstream-gegevens van websites ● GPS-streamgegevens - mobiliteitsgegevens verzonden naar een server ● Sociale media - Facebook, Twitter |

| Volume | De meeste gevallen binnen een bereik van tientallen of honderden GB. Sommige gevallen enkele TB's (1 TB = 1000 GB) | Meer dan een paar Terabytes (TB) |

| Velocity (snelheid waarmee gegevens verschijnen) | ● Gecontroleerde en stabiele gegevensstroom ● De gegevensverzameling is traag | ● Gegevens kunnen zeer hoge snelheden bereiken. ● Enorme gegevens kunnen zich binnen zeer korte tijdsperioden verzamelen |

| Verscheidenheid | Gestructureerde gegevens in tabelvorm met vast schema en semi-gestructureerde gegevens in JSON- of XML-indeling | Grote verscheidenheid aan gegevenssets, waaronder tabelgegevens, tekstbestanden, afbeeldingen, video, audio, XML, JSON, logs, sensorgegevens enz. |

| Waarheid (kwaliteit van gegevens) | Bevat minder ruis omdat gegevens op een gecontroleerde manier worden verzameld. | Meestal is de kwaliteit van de gegevens niet gegarandeerd. Strenge gegevensvalidatie is vereist voor verwerking. |

| Waarde | Business intelligence, analyse en rapportage | Complexe datamining voor voorspelling, aanbeveling, patroonbepaling, etc. |

| Tijdsvariantie | Historische gegevens zijn even geldig als gegevens solide zakelijke interacties vertegenwoordigen | In sommige gevallen worden gegevens snel ouder (bijvoorbeeld fraudedetectie). |

| Gegevenslocatie | Databases binnen een onderneming, lokale servers, enz. | Meestal in gedistribueerde opslag in de cloud of in externe bestandssystemen. |

| Infrastructuur | Voorspelbare toewijzing van middelen. Meestal verticaal schaalbare hardware | Flexibele infrastructuur met een horizontaal schaalbare architectuur. De belasting van het systeem varieert enorm. |

Conclusie - Kleine gegevens versus grote gegevens

Het ultieme doel voor gegevensanalyse om tijdig inzichten te krijgen ter ondersteuning van besluitvorming. Het categoriseren van gegevens in Klein en Groot helpt om uitdagingen aan te gaan bij het analyseren van gegevens van elke wereld afzonderlijk met de juiste tools. De lijn tussen twee categorieën varieert met opkomende geavanceerde gegevensverwerkingssystemen waardoor zelfs het zoeken naar big data veel sneller en minder complex wordt.

Aanbevolen artikelen:

Dit is een gids geweest voor kleine gegevens versus grote gegevens, hun betekenis, vergelijking van persoon tot persoon, belangrijkste verschillen, vergelijkingstabel en conclusie. dit artikel bevat alle belangrijke verschillen tussen Small Data en Big Data. U kunt ook de volgende artikelen bekijken voor meer informatie -

- Big Data versus Data Science - Hoe zijn ze anders?

- Big Data: belangrijk voor Confluence of Technology & Business analytics

- Top 5 Big Data-trends die bedrijven moeten beheersen

- 16 interessante tips om van big data een groot succes te maken