Inleiding tot soorten machine learning-algoritmen

Machine Learning-algoritmetypen of AI-berekeningen zijn programma's (wiskunde en redenering) die zichzelf aanpassen om beter te presteren naarmate ze meer informatie krijgen. Het 'aanpassen' van een deel van AI houdt in dat die projecten de manier veranderen waarop ze informatie na verloop van tijd veranderen, net zoals mensen veranderen hoe ze informatie verwerken door te leren. Een machine learning of AI-berekening is dus een programma met een bepaalde methode om zijn eigen parameters te wijzigen, gezien de kritiek op zijn eerdere verwachtingen van de tentoonstelling over een dataset.

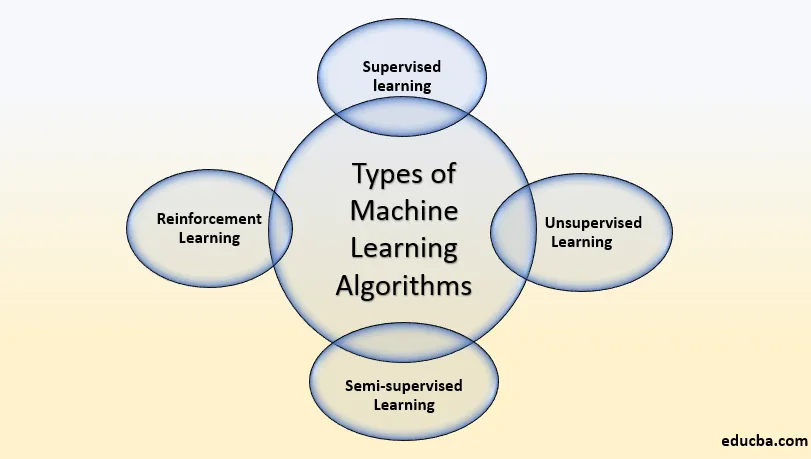

Alle soorten algoritmen voor machine learning

Hun bepaalde variëteiten voor het karakteriseren van de soorten machine learning algoritmen, maar meestal kunnen ze worden onderverdeeld in klassen volgens hun motivatie en de fundamentele classificaties zijn de bijbehorende:

- Leren onder toezicht

- Leren zonder toezicht

- Semi-begeleid leren

- Versterking leren

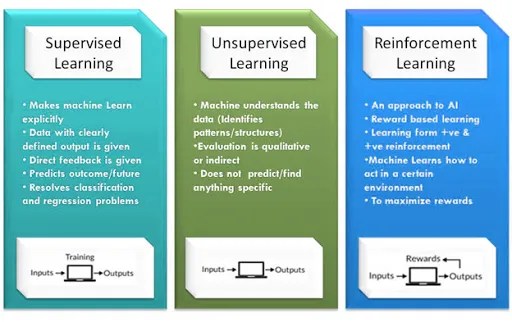

Wat is begeleid leren?

Begeleid leren is, waar u kunt overwegen dat het leren wordt begeleid door een instructeur. We hebben een dataset die rondgaat als een opvoeder en het is zijn taak om het model of de machine voor te bereiden. Wanneer het model wordt voorbereid, kan het beginnen met het vaststellen van een verwachting of keuze wanneer er nieuwe informatie aan wordt gegeven.

Voorbeeld van begeleid leren:

- Je krijgt veel foto's met gegevens over wat erop staat en daarna train je een model om nieuwe foto's waar te nemen.

- Je hebt veel gegevens over huizenprijzen op basis van hun grootte en locatie en je voert het in het model en traint het dan kun je de prijs van andere huizen voorspellen op basis van gegevens die je voedt.

- Als u wilt voorspellen dat uw bericht spam is of niet op basis van een ouder bericht, kunt u voorspellen dat een nieuw bericht spam is of niet.

Het begeleide leeralgoritme is als volgt:

1) Lineaire regressie

lineaire regressie is waardevol voor het ontdekken van het verband tussen twee persistente factoren. De ene is een voorspeller of autonome variabele en de andere is een reactie- of wijkvariabele. Het zoekt naar een meetbare relatie, maar geen deterministische relatie. Het verband tussen twee factoren zou deterministisch zijn voor de kans dat de ene variabele precies door de andere kan worden gecommuniceerd. Met behulp van temperatuur in graden Celsius is het bijvoorbeeld denkbaar om Fahrenheit precies te voorzien. De feitelijke relatie is niet precies bij het bepalen van een verband tussen twee factoren. Bijvoorbeeld verbinding ergens in het bereik van lengte en gewicht. De centrale gedachte is om een lijn te krijgen die het beste bij de informatie past. De best passende regel is die waarvoor all-out voorspelling blunder (alle informatiefocussen) zo weinig is als onder de omstandigheden kan worden verwacht. De fout is de scheiding tussen het punt naar de regressielijn.

2) Beslisbomen

Een beslissingsboom is een beslissingshulpgadget die een boomachtig diagram of beslissingsmodel en hun potentiële resultaten gebruikt, inclusief resultaten voor toevalsgebeurtenissen, kosten van hulpmiddelen en nut. Verken de afbeelding om een gevoel te krijgen van waar het op lijkt.

3) Naïeve Bayes-classificatie

Naïeve Bayes-classificatie een groep van basale probabilistische classificatoren die afhankelijk zijn van de toepassing van de theorie van Bayes met een sterk (niet verfijnd) zelfbestuur, de kenmerken van Naive Bayes. Deze classificatie Enkele van de certificeerbare modellen zijn:

Om een e-mail als spam of niet als spam te stempelen

Bestel een nieuwsbericht over innovatie, overheidsproblemen of sport

Controleer een vleugje substantie positieve emoties of negatieve sentimenten?

Gebruikt voor programmering van gezichtsherkenning.

4) Logistische regressie

Logistische regressie is een baanbrekende feitelijke methode voor het aantonen van een binomiaal resultaat met ten minste één informatieve factor. Het kwantificeert het verband tussen de absolute afdelingsvariabele en ten minste één vrije factor door waarschijnlijkheden te evalueren met behulp van een logistieke capaciteit, wat de gecombineerde logistieke toe-eigening is.

Normaal gesproken zijn regressies bruikbaar in het echte leven, zoals:

Kredietwaardigheid

De maat voor het succespercentage van markt of bedrijf

Om de omzet van een bedrijf of product te voorspellen

Is er op een dag een aardbeving?

5) Regressie van de minste vierkanten

Kleinste vierkanten is een strategie voor het uitvoeren van directe regressie. directe regressie is het streven om een lijn door veel focussen te halen. Er zijn verschillende mogelijke procedures om dit te doen, en het "gewone kleinste kwadraten" -systeem gaat als volgt: u kunt een lijn trekken en daarna voor alle datacenters de verticale afstand tussen het punt en de lijn meten en deze opnemen up; de vaste lijn zou de plaats zijn waar dit geheel van partities zo mager is als normaal zou kunnen zijn in het licht van de huidige situatie.

Wat is leren zonder toezicht?

Het model leert door perceptie en ontdekt structuren in de informatie. Wanneer het model een dataset krijgt, ontdekt het bijgevolg voorbeelden en verbindingen in de dataset door er bosjes in te maken. Wat het niet kan doen, is markeringen toevoegen aan het stel, vergelijkbaar met het kan dit geen verzameling appels of mango's noemen, maar het zal alle appels van mango's isoleren.

Stel dat we afbeeldingen van appels, bananen en mango's aan het model hebben getoond, dus wat het doet, in het licht van bepaalde voorbeelden en verbindingen maakt het trossen en verdeelt de dataset in die groepen. Momenteel wordt er een andere informatie aan het model toegevoegd, deze wordt toegevoegd aan een van de gemaakte bundels.

Voorbeeld van ongecontroleerd leren

- Je hebt veel foto's van 6 personen maar nog geen gegevens over wie zich op welke bevindt en je moet deze dataset in 6 stapels isoleren, elk met de foto's van één persoon.

- Je hebt deeltjes, een deel ervan is medicatie en een deel niet, maar je beseft niet welke dat zal zijn en je hebt de berekening nodig om de medicijnen te vinden.

Het algoritme zonder toezicht is als volgt

clustering

Clustering is een belangrijk idee met betrekking tot zelfstandig leren. Voor het grootste deel slaagt het erin om een structuur of voorbeeld te vinden in een verzameling van niet-gecategoriseerde informatie. Clusterberekeningen verwerken uw informatie en ontdekken karakteristieke clusters (groepen) in het geval dat ze in de informatie voorkomen. U kunt ook wijzigen welk aantal trossen uw berekeningen zouden moeten onderscheiden. Hiermee kunt u de granulariteit van deze bijeenkomsten wijzigen.

Er zijn verschillende soorten clustering die u kunt gebruiken

- Selectief (verdelen)

- Model: K-middelen

- agglomeratief

- Model: Hiërarchische clustering

- Aan het bedekken

- Model: Fuzzy C-Means

- probabilistisch

Clustering algoritme types

- Hiërarchische clustering

- K betekent clustering

- K-NN (k naaste buren)

- Belangrijkste componentenanalyse

- Ontleding van eenzame waarde

- Onafhankelijke componentenanalyse

- Hiërarchische clustering

Hiërarchische clustering

Hiërarchische clustering is een berekening die een pikorde van groepen construeert. Het begint met alle informatie die aan hun eigen groep wordt uitgedeeld. Hier zullen twee hechte groepen in een vergelijkbare groep zitten. Deze berekening wordt gesloten wanneer er nog maar één groep over is.

K betekent Clustering

K betekent dat het een iteratieve clusteringberekening is die u aanmoedigt om voor elke nadruk de meest opmerkelijke prikkel te vinden. Eerst wordt het ideale aantal groepen gekozen. In deze clusteringstechniek moet je de informatie bundelen die zich richt op k-bijeenkomsten. Een grotere k betekent ook kleinere bijeenkomsten met een grotere korreligheid. Een lagere k betekent grotere bijeenkomsten met minder korreligheid.

De opbrengst van de berekening is een verzameling van 'namen'. Hiermee kan informatie naar een van de k-bijeenkomsten verwijzen. In k-betekent clustering wordt elke verzameling gekenmerkt door het maken van een zwaartepunt voor elke verzameling. De zwaartepunten zijn als de kern van het stel, dat de dichtstbijzijnde focussen vangt en ze aan de groep toevoegt.

K-gemiddelde clustering kenmerkt verder twee subgroepen

- Agglomeratieve clustering

- dendrogram

Agglomeratieve clustering

Dit soort K-middelen clustering begint met een vast aantal trossen. Het duidt alle informatie aan in een nauwkeurig aantal groepen. Voor deze clusterstrategie is het aantal groepen K niet vereist als info. Agglomeratieprocedure begint met het vormen van elk gegeven als een eenzame groep.

Deze strategie maakt gebruik van enige scheidingsmaat, vermindert het aantal bossen (één in elke nadruk) door het proces te combineren. Concluderend hebben we één grote groep die alle artikelen bevat.

dendrogram

In de Dendrogram-clusteringstechniek spreekt elk niveau tot een denkbare groep. De lengte van het dendrogram toont de mate van gelijkenis tussen twee samengevoegde trossen. Hoe dichter bij de basis van de procedure, ze zijn geleidelijk vergelijkbare groep die vindt dat de verzameling van dendrogram niet kenmerkend en voor het grootste deel abstract is.

K-dichtstbijzijnde buren

De dichtstbijzijnde buur van K is de meest eenvoudige van alle AI-classificaties. Het verschilt van andere AI-procedures, omdat het geen model oplevert. Het is een eenvoudige berekening waarin elke toegankelijke case wordt opgeslagen en nieuwe voorbeelden worden gekenmerkt die afhankelijk zijn van een gelijkenismaatregel.

Het werkt heel goed als er een scheiding is tussen modellen. De leersnelheid is gematigd wanneer de voorbereidingsset enorm is, en het uitzoeken van de scheiding niet-triviaal is.

Belangrijkste componentenanalyse

Met de kans dat u een hoger-dimensionale ruimte nodig heeft. Je moet een reden voor die ruimte kiezen en alleen de 200 belangrijkste scores van dat uitgangspunt. Deze basis staat bekend als een hoofdcomponent. De subset die u selecteert, is een andere ruimte die klein is in tegenstelling tot een unieke ruimte. Het houdt echter zoveel van de veelzijdige aard van informatie bij als kan worden verwacht.

Wat is versterkingsleren?

Het is het vermogen van een specialist om met de aarde samen te werken en te ontdekken wat het beste resultaat is. Het streeft het idee van hit en voorlopige techniek na. De exploitant wordt vergoed of gestraft met een punt voor een recht of een off-base antwoord, en op basis van de positieve beloningsfocus pikte de modeltreinen zelf op. Ook bereidt het zich, eenmaal voorbereid, voor om de nieuwe informatie te voorzien die eraan is toegevoegd.

Voorbeeld van versterkingsleren

- Het weergeven van advertenties volgens gebruikers die niet leuk vinden, optimaliseert voor de lange termijn

- Weet het advertentiebudget dat in realtime wordt gebruikt

- omgekeerde versterking leren om klanten zoals antipathieën beter te leren kennen

Wat is semi-begeleid leren?

Semi-begeleide vorm van leren, de berekening is voorbereid op een mix van benoemde en niet-gelabelde informatie. Normaal gesproken bevat deze blend een beperkte hoeveelheid benoemde informatie en veel ongelabelde informatie. De fundamentele methode die is inbegrepen, is dat de software-ingenieur eerst vergelijkbare informatie groepeert met behulp van een rekenhulp zonder hulp en daarna de huidige benoemde informatie gebruikt om de rest van de niet-gelabelde informatie te benoemen. De voorbeelden van normaal gebruik van een dergelijke berekening hebben een typische eigenschap - Het verkrijgen van niet-gelabelde informatie is over het algemeen bescheiden, terwijl het benoemen van de genoemde informatie te duur is. Natuurlijk kan men zich de drie soorten leerberekeningen voorstellen als Supervised realiseren waar een understudy onder toezicht staat van een instructeur zowel thuis als op school, Unsupervised die realiseert waar een understudy zelf een idee moet begrijpen en Semi-Supervised realiseren waar een opvoeder toont een aantal ideeën in de klas en geeft als schoolwerk vragen die afhankelijk zijn van vergelijkbare ideeën.

Voorbeeld van semi-begeleid leren

Het is opmerkelijk dat meer informatie = modellen van betere kwaliteit in diepgaand leren (tot een specifiek punt van opsluiting duidelijk, maar vaker wel dan niet hebben we niet zoveel informatie.) Hoe dan ook, het krijgen van gemarkeerde informatie is kostbaar. Als u een model moet voorbereiden om gevleugelde dieren te onderscheiden, kunt u veel camera's instellen om bijgevolg foto's van vogels te maken. Dat is over het algemeen bescheiden. Individuen contracteren om die foto's te markeren is kostbaar. Overweeg de mogelijkheid dat je een enorm aantal foto's van gevleugelde dieren hebt, maar contracteer individuen gewoon om een kleine subset van de foto's te markeren. Het bleek dat je, in plaats van alleen de modellen op de gemarkeerde subset te trainen, het model vooraf op de hele trainingsset kunt trainen, voordat je het met de genoemde subset aanpast, en je vertoont tekenen van verbetering volgens deze lijnen. Dat is semi-begeleid leren. Het zet uw geld opzij.

Conclusie

Er zijn veel soorten machine learning-algoritmen en op basis van verschillende omstandigheden moeten we het best passende algoritme gebruiken voor het beste resultaat. Er zijn veel algoritmen die de beste nauwkeurigheid van elk type machine learning-algoritme vinden en die de hoogste nauwkeurigheid is die we moeten gebruiken. We kunnen de fout van elk algoritme minimaliseren door ruis in gegevens te verminderen. Eindelijk zal ik zeggen dat er geen enkel machine-learning algoritme is dat je 100 procent nauwkeurigheid kan geven, zelfs het menselijk brein kan dat niet, dus vind het beste fir-algoritme voor je gegevens.

Aanbevolen artikelen

Dit is een gids voor soorten machine learning algoritmen. Hier bespreken we Wat is Machine learning Algorithm ?, en de typen omvatten Supervised Learning, Unsupervised Learning, Semi-Supervised Learning, versterkingsleren. U kunt ook de volgende artikelen bekijken voor meer informatie -

- Machine leermethoden

- Machine Learning-bibliotheken

- Machine Learning-modellen

- Machine Learning Frameworks

- Machine leren van hyperparameter

- Hiërarchische clustering | Agglomerative & Divisive Clustering

- Maak beslisboom | Hoe | voordelen

- Levenscyclus van machine learning | Top 8 fasen