Inleiding tot big data-architectuur

Als het gaat om het beheren van zware gegevens en het uitvoeren van complexe bewerkingen op die enorme gegevens, wordt het nodig om big data-tools en -technieken te gebruiken. Als we zeggen dat we big data-tools en -technieken gebruiken, bedoelen we in feite dat we vragen om gebruik te maken van verschillende software en procedures die in het big data-ecosysteem en zijn sfeer liggen. Er is geen generieke oplossing die voor elke use case wordt geboden en daarom moet deze op een effectieve manier worden gemaakt en gemaakt volgens de zakelijke vereisten van een bepaald bedrijf. Er wordt dus behoefte aan het gebruik van verschillende big data-architectuur, omdat de combinatie van verschillende technologieën ertoe zal leiden dat de resulterende use case wordt bereikt. Door een vaste architectuur tot stand te brengen, kan ervoor worden gezorgd dat voor de gevraagde use case een haalbare oplossing wordt geboden.

Wat is big data-architectuur?

- Deze architectuur is zo ontworpen dat deze het opnameproces, de verwerking van gegevens en de analyse van de gegevens uitvoert, wat veel te groot of complex is om de traditionele databasebeheersystemen aan te kunnen.

- Verschillende organisaties hebben verschillende drempels voor hun organisaties, sommige hebben het voor een paar honderd gigabytes, terwijl voor anderen zelfs sommige terabytes niet goed genoeg zijn als drempelwaarde.

- Als gevolg van deze gebeurtenis die zich voordoet als u naar de commodity-systemen en de commodity-opslag kijkt, zijn de waarden en de opslagkosten aanzienlijk verlaagd. Er is een enorme verscheidenheid aan gegevens die verschillende manieren vereisen om te worden verzorgd.

- Sommigen van hen zijn batchgerelateerde gegevens die op een bepaald moment komen en daarom moeten de taken op een vergelijkbare manier worden gepland, terwijl anderen behoren tot de streamingklasse waar een realtime streamingpijplijn moet worden gebouwd om tegemoet te komen aan alle voorwaarden. Al deze uitdagingen worden opgelost door big data-architectuur.

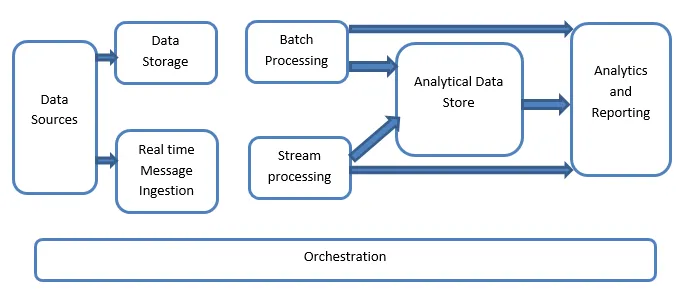

Verklaring van Big Data-architectuur:

Big Data-systemen omvatten meer dan één workloadtype en ze zijn globaal als volgt ingedeeld:

- Waar de op grote gegevens gebaseerde bronnen in rust zijn, is batchverwerking betrokken.

- Grote gegevensverwerking in beweging voor realtime verwerking.

- Verkenning van interactieve big data-tools en technologieën.

- Machine learning en voorspellende analyse.

1. Gegevensbronnen

De gegevensbronnen betreffen al die gouden bronnen waaruit de gegevensextractiepijplijn is gebouwd en daarom kan worden gezegd dat dit het startpunt is van de big data-pijplijn.

De voorbeelden omvatten:

(i) Datastores van applicaties zoals die zoals relationele databases

(ii) De bestanden die worden geproduceerd door een aantal toepassingen en die hoofdzakelijk deel uitmaken van statische bestandssystemen zoals webgebaseerde serverbestanden die logbestanden genereren.

(iii) IoT-apparaten en andere realtime-gebaseerde gegevensbronnen.

2. Gegevensopslag

Dit omvat de gegevens die worden beheerd voor de batchgebouwde bewerkingen en worden opgeslagen in de bestandsarchieven die in de natuur worden gedistribueerd en ook in staat zijn grote volumes grote bestanden met verschillende indelingen te back-uppen. Het wordt het gegevensmeer genoemd. Dit vormt in het algemeen het gedeelte waar onze Hadoop-opslag zoals HDFS, Microsoft Azure, AWS, GCP-opslag wordt geleverd samen met blob-containers.

3. Batch-verwerking

Alle gegevens zijn gescheiden in verschillende categorieën of brokken die gebruik maken van langlopende taken die worden gebruikt om te filteren en aggregeren en ook gegevens in verwerkte staat voor analyse voor te bereiden. Deze taken maken meestal gebruik van bronnen, verwerken ze en leveren de output van de verwerkte bestanden aan de nieuwe bestanden. De batchverwerking wordt op verschillende manieren gedaan door gebruik te maken van Hive-taken of op U-SQL gebaseerde taken of door gebruik te maken van Sqoop of Pig samen met de aangepaste kaartreductietaken die over het algemeen worden geschreven in een van de Java of Scala of een andere taal zoals Python.

4. Op tijd gebaseerde berichtinname

Dit omvat, in tegenstelling tot de batchverwerking, al die realtime streaming-systemen die ervoor zorgen dat de gegevens sequentieel en in een vast patroon worden gegenereerd. Dit is vaak een eenvoudige datamart of -winkel die verantwoordelijk is voor alle inkomende berichten die in de map worden geplaatst die noodzakelijkerwijs wordt gebruikt voor gegevensverwerking. Er zijn echter de meeste oplossingen die de behoefte vereisen van een op berichten gebaseerde opname-opslag die fungeert als een berichtenbuffer en ook de op schaal gebaseerde verwerking ondersteunt, biedt een relatief betrouwbare aflevering samen met andere semantiek voor berichtenwachtrijen. De opties omvatten die zoals Apache Kafka, Apache Flume, Event hubs van Azure, etc.

5. Stroomverwerking

Er is een klein verschil tussen de realtime opname van berichten en streamverwerking. De eerste houdt rekening met de ingenomen gegevens die eerst worden verzameld en vervolgens worden gebruikt als een soort publicatietool. Streamverwerking daarentegen wordt gebruikt om al die streaminggegevens die zich in vensters of streams voordoen af te handelen en schrijft de gegevens vervolgens naar de output-sink. Dit omvat Apache Spark, Apache Flink, Storm, etc.

6. Op Analytics gebaseerde gegevensopslag

Dit is de gegevensopslag die wordt gebruikt voor analytische doeleinden en daarom worden de reeds verwerkte gegevens vervolgens opgevraagd en geanalyseerd met behulp van analysetools die kunnen overeenkomen met de BI-oplossingen. De gegevens kunnen ook worden gepresenteerd met behulp van een NoSQL-datawarehouse-technologie zoals HBase of elk interactief gebruik van een bijenkorfdatabase die de metadata-abstractie in de gegevensopslag kan bieden. Tools omvatten Hive, Spark SQL, Hbase, etc.

7. Rapportage en analyse

De inzichten moeten worden gegenereerd op de verwerkte gegevens en dat wordt effectief gedaan door de rapportage- en analysehulpmiddelen die gebruik maken van hun ingebedde technologie en oplossing om nuttige grafieken, analyses en inzichten te genereren die nuttig zijn voor de bedrijven. Hulpmiddelen zijn Cognos, Hyperion, etc.

8. Bezetting

Op big-data gebaseerde oplossingen bestaan uit gegevensgerelateerde bewerkingen die repetitief van aard zijn en ook zijn ingekapseld in de workflows die de brongegevens kunnen transformeren en ook gegevens over bronnen kunnen verplaatsen, evenals gootstenen en laden in winkels en push in analytische eenheden. Voorbeelden hiervan zijn Sqoop, oozie, datafabriek, etc.

Conclusie

In dit bericht lezen we over de big data-architectuur die nodig is om deze technologieën in het bedrijf of de organisatie te implementeren. Ik hoop dat je ons artikel leuk vond.

Aanbevolen artikelen

Dit is een handleiding voor Big Data Architecture geweest. Hier bespreken we wat big data is? en ook hebben we de architectuur van big data uitgelegd samen met het blokdiagram. U kunt ook onze andere voorgestelde artikelen doornemen voor meer informatie -

- Big Data-technologieën

- Big Data Analytics

- Carrières in Big Data

- Big Data-interviewvragen

- Top 8 apparaten van IoT die u moet kennen

- Soorten joins in Spark SQL (voorbeelden)