Wat is Hadoop?

Voordat u de voordelen van Hadoop begrijpt, moet u eerst de Hadoop begrijpen. Hadoop is een groot paradigma voor gegevensverwerking dat een betrouwbare, schaalbare plaats biedt voor gegevensopslag en -verwerking. Hadoop is gemaakt door Doug Cutting en hij wordt beschouwd als "Vader van Hadoop". Hadoop was de naam van de speelgoedolifant van zijn zoon. Hadoop had zijn wortels in het Nutch Search Engine Project. Hadoop is een verwerkingsraamwerk dat enorme veranderingen heeft gebracht in de manier waarop we de gegevens verwerken, de manier waarop we de gegevens opslaan. In vergelijking met traditionele verwerkingstools zoals RDBMS heeft Hadoop bewezen dat we de uitdagingen van Big data zoals:

Verscheidenheid aan gegevens: Hadoop kan gestructureerde en semi-gestructureerde en ongestructureerde gegevensindelingen opslaan en verwerken.

De hoeveelheid gegevens : Hadoop is speciaal ontworpen om de enorme hoeveelheid gegevens in het bereik van petabytes aan te kunnen.

De snelheid van gegevens : Hadoop kan petabytes aan gegevens met hoge snelheid verwerken in vergelijking met andere verwerkingstools zoals RDBMS, dwz de verwerkingstijd in Hadoop is heel kort.

Opvallende kenmerken van Hadoop

- Hadoop is open-source van aard.

- Het werkt op een cluster van machines. De grootte van het cluster is afhankelijk van de vereisten.

- Het kan op normale basisapparatuur draaien.

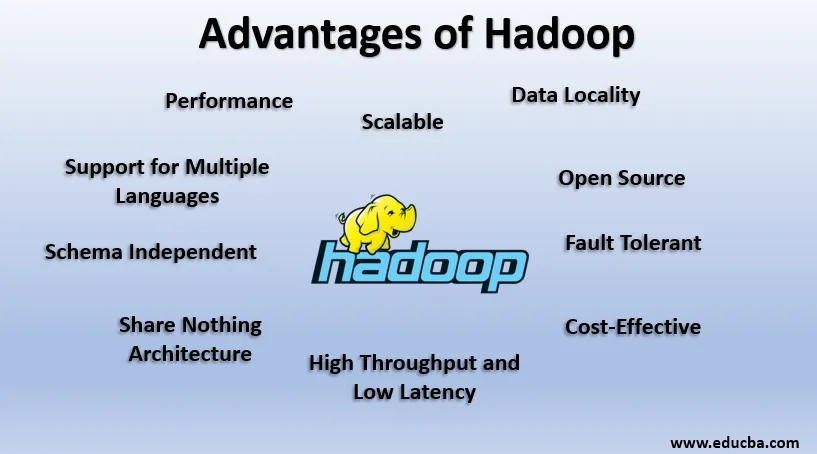

Voordelen van Hadoop

In deze sectie worden de voordelen van Hadoop besproken. Laten we ze nu een voor een bekijken:

1. Open bron

Hadoop is open-source van aard, dat wil zeggen dat de broncode vrij beschikbaar is. We kunnen de broncode aanpassen volgens onze zakelijke vereisten. Zelfs eigen versies van Hadoop zoals Cloudera en Horton werken zijn ook beschikbaar.

2. Schaalbaar

Hadoop werkt op het cluster van machines. Hadoop is zeer schaalbaar. We kunnen de omvang van ons cluster vergroten door nieuwe knooppunten toe te voegen zonder enige downtime. Deze manier om nieuwe machines aan het cluster toe te voegen, staat bekend als horizontale schaling, terwijl het vergroten van componenten zoals het verdubbelen van de harde schijf en RAM bekend staat als verticale schaling.

3. Fouttolerant

Fouttolerantie is het meest opvallende kenmerk van Hadoop. Standaard heeft elk blok in HDFS een replicatiefactor van 3. Voor elk gegevensblok maakt HDFS nog twee kopieën en slaat deze op een andere locatie in het cluster op. Als een blok ontbreekt door een machinestoring, hebben we nog twee exemplaren van hetzelfde blok en die worden gebruikt. Op deze manier wordt fouttolerantie bereikt in Hadoop.

4. Onafhankelijk schema

Hadoop kan op verschillende soorten gegevens werken. Het is flexibel genoeg om verschillende gegevensformaten op te slaan en kan zowel met schema (gestructureerde) als zonder schema (ongestructureerde) aan gegevens werken.

5. Hoge doorvoer en lage latentie

Doorvoer betekent hoeveelheid werk dat is gedaan per tijdseenheid en Lage latentie betekent dat de gegevens zonder vertraging of minder vertraging worden verwerkt. Omdat Hadoop wordt aangedreven door het principe van gedistribueerde opslag en parallelle verwerking, wordt de verwerking tegelijkertijd op elk gegevensblok uitgevoerd en onafhankelijk van elkaar. In plaats van gegevens te verplaatsen, wordt code ook verplaatst naar gegevens in het cluster. Deze twee dragen bij aan High Throughput en Low Latency.

6. Gegevenslocatie

Hadoop werkt volgens het principe van "Verplaats de code, geen gegevens". In Hadoop blijven gegevens stationair en voor de verwerking van gegevens wordt code verplaatst naar gegevens in de vorm van taken, dit staat bekend als gegevenslocatie. Omdat we te maken hebben met gegevens in het bereik van petabytes, wordt het zowel moeilijk als duur om de gegevens over het netwerk te verplaatsen. Gegevenslocaliteit zorgt ervoor dat gegevensbewegingen in het cluster minimaal zijn.

7. Prestaties

In Legacy-systemen zoals RDBMS worden gegevens sequentieel verwerkt, maar in Hadoop begint de verwerking op alle blokken tegelijk waardoor Parallel Processing wordt geboden. Dankzij parallelle verwerkingstechnieken zijn de prestaties van Hadoop veel hoger dan bij oudere systemen zoals RDBMS. In 2008 versloeg Hadoop zelfs de snelste Supercomputer die op dat moment aanwezig was.

8. Share Nothing Architecture

Elk knooppunt in het Hadoop-cluster is onafhankelijk van elkaar. Ze delen geen bronnen of opslag, deze architectuur staat bekend als Share Nothing Architecture (SN). Als een knooppunt in het cluster uitvalt, wordt het hele cluster niet verwijderd omdat elk knooppunt onafhankelijk werkt, waardoor een enkel punt van mislukking wordt geëlimineerd.

9. Ondersteuning voor meerdere talen

Hoewel Hadoop voornamelijk in Java werd ontwikkeld, biedt het ook ondersteuning voor andere talen zoals Python, Ruby, Perl en Groovy.

10. Rendabel

Hadoop is erg zuinig van aard. We kunnen een Hadoop-cluster bouwen met normale standaardhardware, waardoor de hardwarekosten worden verlaagd. Volgens het Cloud-tijdperk zijn de kosten voor gegevensbeheer van Hadoop, dat wil zeggen zowel hardware en software als andere kosten, zeer minimaal in vergelijking met traditionele ETL-systemen.

11. Abstractie

Hadoop biedt abstractie op verschillende niveaus. Het maakt het werk eenvoudiger voor ontwikkelaars. Een groot bestand wordt opgedeeld in blokken van dezelfde grootte en opgeslagen op verschillende locaties in het cluster. Bij het maken van de kaartreductietaak moeten we ons zorgen maken over de locatie van blokken. We geven een compleet bestand als invoer en het Hadoop-framework zorgt voor de verwerking van verschillende gegevensblokken op verschillende locaties. Hive is een onderdeel van het Hadoop-ecosysteem en het is een abstractie bovenop Hadoop. Omdat Map-Reduce-taken op Java zijn geschreven, konden SQL-ontwikkelaars over de hele wereld niet profiteren van Map Reduce. Daarom wordt Hive geïntroduceerd om dit probleem op te lossen. We kunnen SQL-achtige zoekopdrachten op Hive schrijven, die op hun beurt Map-opdrachten activeren. Dankzij Hive kan de SQL-community dus ook werken aan Map Reduce-taken.

12. Compatibiliteit

In Hadoop is HDFS de opslaglaag en Map Reduce is de verwerkingsengine. Maar er is geen rigide regel dat Map Reduce standaard Processing Engine moet zijn. Nieuwe verwerkingskaders zoals Apache Spark en Apache Flink gebruiken HDFS als opslagsysteem. Zelfs in Hive kunnen we ook onze Execution Engine wijzigen in Apache Tez of Apache Spark volgens onze vereisten. Apache HBase, NoSQL Columnar Database, gebruikt HDFS voor de opslaglaag.

13. Ondersteuning voor verschillende bestandssystemen

Hadoop is zeer flexibel van aard. Het kan verschillende gegevensformaten opnemen, zoals afbeeldingen, video's, bestanden, enz. Het kan ook gestructureerde en ongestructureerde gegevens verwerken. Hadoop ondersteunt verschillende bestandssystemen zoals JSON, XML, Avro, Parquet, etc.

Werken van Hadoop

Hieronder staan de punten die laten zien hoe Hadoop werkt:

1. Gedistribueerde opslag en parallelle verwerking

Dit is het drijvende principe van alle frameworks van het Hadoop Ecosystem inclusief Apache Spark. Om de werking van Hadoop en Spark te begrijpen, moeten we eerst begrijpen wat "Gedistribueerde opslag en parallelle verwerking" is.

2. Gedistribueerde opslag

Hadoop slaat geen gegevens op in een enkele machine. In plaats daarvan splitst het die enorme gegevens op in blokken van gelijke grootte die standaard 256 MB zijn en slaat die blokken op in verschillende knooppunten van een cluster (werkknooppunten). Het slaat de metagegevens van die blokken op in het hoofdknooppunt. Deze manier om het bestand op gedistribueerde locaties in een cluster op te slaan, staat bekend als Hadoop distributed File System - HDFS.

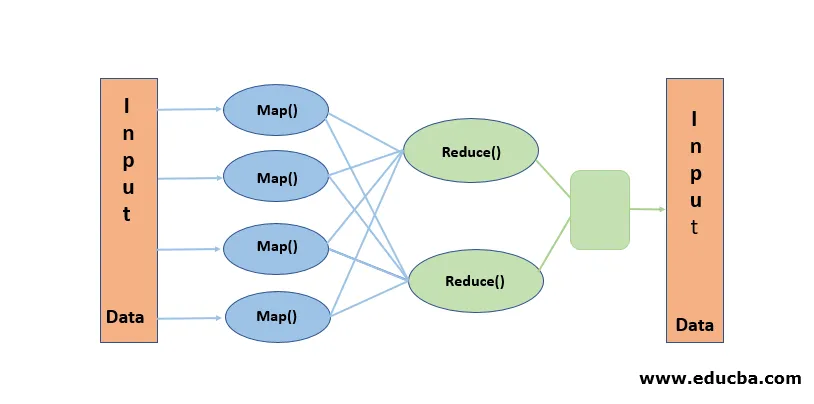

3. Parallelle verwerking

Het is een verwerkingsparadigma, waarbij de verwerking gelijktijdig wordt uitgevoerd op de gegevensblokken die zijn opgeslagen in HDFS. Parallelle verwerking werkt volgens het begrip "Verplaats de code, geen gegevens". Gegevens blijven stationair in HDFS, maar code wordt verplaatst naar gegevens voor verwerking. In eenvoudige bewoordingen: als ons bestand in 100 blokken wordt opgesplitst, worden er 100 kopieën van de taak gemaakt en reizen ze door het cluster naar de locatie waar het blok zich bevindt en de verwerking op 100 blokken tegelijkertijd begint (kaartfase). Uitvoergegevens van alle blokken worden verzameld en gereduceerd tot de uiteindelijke uitvoer (fase verminderen). Map Reduce wordt beschouwd als "Heart of Hadoop".

Conclusie-voordelen van Hadoop

In dit Data-tijdperk heeft Hadoop de weg geëffend voor een andere aanpak van uitdagingen die Big data met zich meebrengt. Als we zeggen, Hadoop bedoelen we niet alleen Hadoop, het bevat Hadoop Ecosystem-tools zoals Apache Hive die SQL-achtige bewerkingen biedt bovenop Hadoop, Apache Pig, Apache HBase voor Columnar-opslagdatabase, Apache Spark voor verwerking in het geheugen en veel meer. Hoewel Hadoop zijn eigen nadelen heeft, is het zeer aanpasbaar en evolueert voortdurend met elke release.

Aanbevolen artikelen

Dit is een gids voor de voordelen van Hadoop. Hier bespreken we wat de Hadoop en de belangrijkste voordelen van Hadoop zijn. U kunt ook onze andere gerelateerde artikelen doornemen voor meer informatie-

- HADOOP Framework

- Wat is Hadoop Cluster?

- Wat is MapReduce in Hadoop?

- Hadoop-database

- Wat is Hadoop? | Toepassingen en functies