Overzicht van verliesfuncties bij machinaal leren

Net zoals leraren ons begeleiden, of we nu goed presteren of niet in onze academici, doen verliesfuncties hetzelfde werk. Het is een methode om te evalueren hoe goed ons algoritme de gegevens modelleert. Verliesfuncties zijn de belangrijkste evaluatiebron bij modern machinaal leren. Wanneer u uw algoritme wijzigt om uw model te verbeteren, zal de verliesfunctiewaarde u vertellen of u vooruitgang boekt of niet. Ons primaire doel zou moeten zijn om de verliesfunctie te verminderen door optimalisatie. In dit artikel gaan we bespreken hoe verliesfuncties werken en verschillende soorten verliesfuncties.

Hoe werkt verliesfuncties?

Het woord 'verlies' vermeldt de straf voor het niet bereiken van de verwachte output. Als de afwijking in de voorspelde waarde dan de verwachte waarde van ons model groot is, geeft de verliesfunctie het hogere getal als uitvoer en als de afwijking klein is en veel dichter bij de verwachte waarde, wordt een kleiner aantal uitgevoerd.

Hier is een voorbeeld wanneer we proberen de verkoopprijs van huizen in metrosteden te voorspellen.

| Voorspelde

Verkoopprijs (in lakh) | werkelijk

Verkoopprijs (in lakh) | Afwijking (verlies) |

| Bangalore: 45 | 0 (Alle voorspellingen zijn correct) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh voor Bangalore, 2 lakh voor Chennai |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh voor Bangalore, 5 lakh voor, Pune2 lakh voor Chennai, | |

| Pune: 30 | ||

| Chennai: 45 |

Het is belangrijk op te merken dat de hoeveelheid afwijking er niet toe doet, wat hier van belang is, is of de door ons model voorspelde waarde goed of fout is. Verliesfuncties verschillen op basis van uw probleemstelling waarop machine learning wordt toegepast. De kostenfunctie is een andere term, die door elkaar wordt gebruikt voor de verliesfunctie, maar heeft een iets andere betekenis. Een verliesfunctie is voor een enkel trainingsvoorbeeld, terwijl de kostenfunctie het gemiddelde verlies is over de volledige treinsdataset.

Soorten verliesfuncties bij machinaal leren

Hieronder staan de verschillende soorten verliesfuncties in machine learning die als volgt zijn:

1) Regressieverliesfuncties:

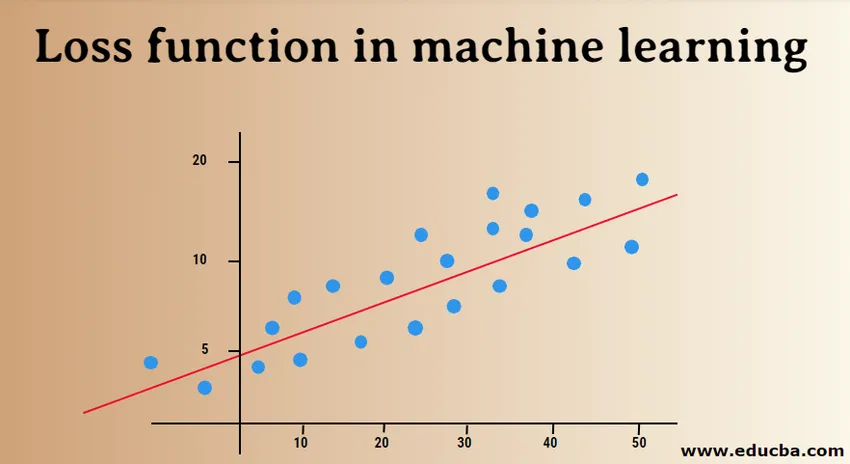

Lineaire regressie is een fundamenteel concept van deze functie. Regressieverliesfuncties vestigen een lineair verband tussen een afhankelijke variabele (Y) en onafhankelijke variabele (X), daarom proberen we de beste regel in de ruimte op deze variabelen te passen.

Y = X0 + X1 + X2 + X3 + X4…. + Xn

X = Onafhankelijke variabelen

Y = Afhankelijke variabele

- Gemiddeld kwadraatfoutverlies:

MSE (L2-fout) meet het gemiddelde kwadraatverschil tussen de werkelijke en voorspelde waarden door het model. De uitvoer is een enkel getal dat is gekoppeld aan een set waarden. Ons doel is om MSE te verminderen om de nauwkeurigheid van het model te verbeteren.

Beschouw de lineaire vergelijking, y = mx + c, we kunnen MSE afleiden als:

MSE = 1 / N ∑i = 1 tot n (y (i) - (mx (i) + b)) 2

Hier is N het totale aantal gegevenspunten, 1 / N ∑i = 1 tot n is de gemiddelde waarde en y (i) is de werkelijke waarde en mx (i) + b de voorspelde waarde.

- Gemiddeld gekwadrateerd logaritmisch foutverlies (MSLE):

MSLE meet de verhouding tussen werkelijke en voorspelde waarde. Het introduceert een asymmetrie in de foutcurve. MSLE geeft alleen om procentueel verschil werkelijke en voorspelde waarden. Het kan een goede keuze zijn als verliesfunctie, wanneer we de verkoopprijzen van huizen, de verkoopprijzen van bakkerijproducten willen voorspellen en de gegevens continu zijn.

Hier kan het verlies worden berekend als het gemiddelde van waargenomen gegevens van de gekwadrateerde verschillen tussen de log-getransformeerde werkelijke en voorspelde waarden, die kunnen worden gegeven als:

L = 1nnΣi 1 = (log (y (i) 1) -log (y (i) 1)) 2

- Mean Absolute Error (MAE):

MAE berekent de som van absolute verschillen tussen werkelijke en voorspelde variabelen. Dat betekent dat het de gemiddelde grootte van fouten meet in een reeks voorspelde waarden. Het gebruik van de gemiddelde kwadratische fout is eenvoudiger op te lossen, maar het gebruik van de absolute fout is robuuster voor uitbijters. Uitbijters zijn die waarden, die sterk afwijken van andere waargenomen gegevenspunten.

MAE kan worden berekend als:

L = 1nnΣi = 1||y (i) - y (i) ||

2) Binaire classificatie verliesfuncties:

Deze verliesfuncties zijn gemaakt om de prestaties van het classificatiemodel te meten. Hierin krijgen gegevenspunten een van de labels toegewezen, ofwel 0 of 1. Verder kunnen ze worden geclassificeerd als:

- Binaire kruis-entropie

Het is een standaardverliesfunctie voor binaire classificatieproblemen. Cross-entropieverlies berekent de prestaties van een classificatiemodel dat een uitvoer van een waarschijnlijkheidswaarde tussen 0 en 1 geeft. Cross-entropieverlies neemt toe naarmate de voorspelde waarschijnlijkheidswaarde afwijkt van het werkelijke label.

- Scharnierverlies

Scharnierverlies kan worden gebruikt als alternatief voor cross-entropie, dat aanvankelijk werd ontwikkeld om te gebruiken met een ondersteuningsvectormachine-algoritme. Scharnierverlies werkt het beste met classificatieprobleem omdat doelwaarden in de set van (-1, 1) liggen. Hiermee kunt u meer fouten toewijzen wanneer er een verschil in teken is tussen werkelijke en voorspelde waarden. Dit resulteert in betere prestaties dan cross-entropie.

- Vierkant scharnierverlies

Een uitbreiding van het scharnierverlies, dat eenvoudig het kwadraat van de score voor het scharnierverlies berekent. Het vermindert de foutfunctie en maakt het numeriek eenvoudiger om mee te werken. Het vindt de classificatiegrens die de maximale marge tussen de gegevenspunten van verschillende klassen aangeeft. Kwadraatscharnierverlies past perfect voor JA OF NEE soort beslissingsproblemen, waarbij waarschijnlijkheidsafwijking niet de zorg is.

3) Multi-class classificatie verliesfuncties:

Indeling in meerdere klassen zijn de voorspellende modellen waarin de gegevenspunten aan meer dan twee klassen worden toegewezen. Elke klasse krijgt een unieke waarde van 0 tot (Number_of_classes - 1). Het wordt sterk aanbevolen voor problemen met de beeld- of tekstclassificatie, waarbij enkel papier meerdere onderwerpen kan hebben.

- Cross-Entropy van meerdere klassen

In dit geval zijn de doelwaarden in de set van 0 tot n, dwz (0, 1, 2, 3… n). Het berekent een score die een gemiddeld verschil neemt tussen de werkelijke en voorspelde waarschijnlijkheidswaarden en de score wordt geminimaliseerd om de best mogelijke nauwkeurigheid te bereiken. Cross-entropie met meerdere klassen is de standaardverliesfunctie voor problemen met tekstclassificatie.

- Schaarse cross-entropie van meerdere klassen

Eén hot coderingsproces maakt cross-entropie van meerdere klassen moeilijk om een groot aantal gegevenspunten te verwerken. Dunne cross-entropie lost dit probleem op door de foutberekening uit te voeren zonder eenmalige codering.

- Kullback Leibler Divergence Loss

KL-divergentieverlies berekent de divergentie tussen waarschijnlijkheidsverdeling en basislijnverdeling en ontdekt hoeveel informatie verloren gaat in termen van bits. De output is een niet-negatieve waarde die aangeeft hoe dicht twee kansverdelingen zijn. Om KL-divergentie te beschrijven in termen van probabilistische weergave, wordt de waarschijnlijkheidsratio gebruikt.

In dit artikel begrepen we in eerste instantie hoe verliesfuncties werken en vervolgens gingen we op zoek naar een uitgebreide lijst met verliesfuncties met voorbeelden van gebruikte gevallen. Praktisch begrijpen is echter voordeliger, dus probeer meer te lezen en te implementeren. Het zal je twijfels grondig verhelderen.

Aanbevolen artikelen

Dit is een gids voor verliesfuncties bij machinaal leren. Hier bespreken we hoe de verliesfuncties werken en de soorten verliesfuncties bij machinaal leren. U kunt ook de volgende artikelen bekijken voor meer informatie -

- Machine leermethoden

- Inleiding tot machinaal leren

- Big Data-technologieën

- Big Data Analytics-software

- Leer de categorieën van Hyperparameter

- Levenscyclus van machine learning | Top 8 fasen