Inleiding tot beslissingsboom in machinaal leren

Decision Tree in Machine Learning heeft een breed terrein in de moderne wereld. Er zijn veel algoritmen in ML die in ons dagelijks leven worden gebruikt. Een van de belangrijke algoritmen is Decision Tree die wordt gebruikt voor classificatie en ook een oplossing voor regressieproblemen. Omdat het een voorspellend model is, gebeurt de analyse van de beslissingsboom via een algoritmische aanpak waarbij een gegevensset volgens voorwaarden wordt opgesplitst in subsets. De naam zelf zegt dat het een boomachtig model is in de vorm van if-then-else-verklaringen. Hoe dieper de boom is en hoe meer knopen, hoe beter het model.

Soorten beslissingsboom in machinaal leren

Beslisboom is een boomachtige grafiek waarbij het sorteren begint van de wortelknoop tot de bladknoop totdat het doel is bereikt. Het is de meest populaire voor beslissingen en classificatie op basis van bewaakte algoritmen. Het is opgebouwd door recursieve partitie waarbij elke knoop als testcase fungeert voor sommige attributen en elke rand, afgeleid van de knoop, een mogelijk antwoord is in de testcase. Zowel de basis- als de bladknooppunten zijn twee entiteiten van het algoritme.

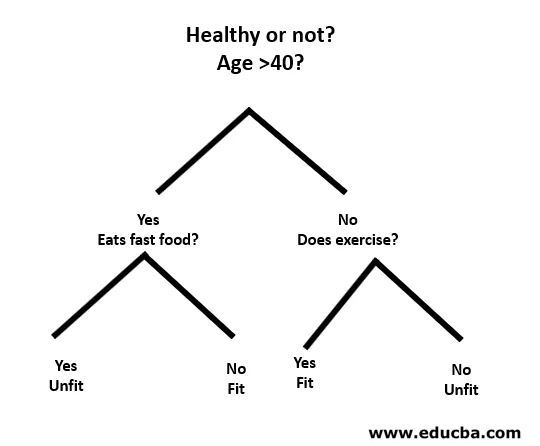

Laten we het met behulp van een klein voorbeeld als volgt begrijpen:

Hier is het hoofdknooppunt of u minder dan 40 bent of niet. Zo ja, eet je dan fastfood? Zo ja, dan ben je ongeschikt, of anders ben je fit. En als je ouder bent dan 40, oefen je dan? Als dat zo is, dan ben je fit, of anders ben je ongeschikt. Dit was eigenlijk een binaire classificatie.

Er zijn twee soorten beslissingsbomen:

- Classificatiebomen: het bovenstaande voorbeeld is een op categorieën gebaseerde classificatieboom.

- Regressiebomen : in dit type algoritme is de beslissing of het resultaat continu. Het heeft een enkele numerieke uitgang met meer ingangen of voorspellers.

In de beslissingsboom is de typische uitdaging om het kenmerk bij elk knooppunt te identificeren. Het proces wordt kenmerkselectie genoemd en moet worden gebruikt om het kenmerk te identificeren.

een. Informatiewinst (IG)

Information Gain meet hoeveel informatie een individuele functie over de klas geeft. Het fungeert als de belangrijkste sleutel om een beslissingsboom te construeren. Een attribuut met de hoogste informatiewinst splitst eerst. Dus, Decision Tree maximaliseert altijd de informatiewinst. Wanneer we een knooppunt gebruiken om de instanties in kleinere subsets te partitioneren, verandert de entropie.

Entropie: het is de maat voor onzekerheid of onzuiverheid in een willekeurige variabele. Entropy bepaalt hoe een beslissingsboom de gegevens opsplitst in subsets.

De vergelijking voor informatiewinst en entropie is als volgt:

Informatiewinst = entropie (ouder) - (gewogen gemiddelde * entropie (kinderen))

Entropie: ∑p (X) log p (X)

P (X) is hier de fractie van voorbeelden in een bepaalde klasse.

b. Gini Index

Gini Index is een statistiek die bepaalt hoe vaak een willekeurig gekozen element onjuist zou worden geïdentificeerd. Er staat duidelijk dat attribuut met een lage Gini-index de eerste voorkeur heeft.

Gini-index: 1-∑ p (X) 2

Creatie splitsen

- Om een splitsing te maken, moeten we eerst de Gini-score berekenen.

- De gegevens worden gesplitst met behulp van een lijst met rijen met een index van een kenmerk en een gesplitste waarde van dat kenmerk. Nadat de gegevensset rechts en links is gevonden, kunnen we de gesplitste waarde krijgen op basis van de Gini-score uit het eerste deel. Nu zal de gesplitste waarde de beslisser zijn waar het kenmerk zich zal bevinden.

- Het volgende deel evalueert alle splitsingen. De best mogelijke waarde wordt berekend door de kosten van de splitsing te evalueren. De beste splitsing wordt gebruikt als een knooppunt van de beslissingsboom.

Een boom bouwen - beslissingsboom in machinaal leren

Er zijn twee stappen om een beslissingsboom te bouwen.

1. Eindknooppunt maken

Bij het maken van het eindknooppunt is het belangrijk om op te merken of we moeten stoppen met het groeien van bomen of verder moeten gaan. Hiervoor kunnen de volgende manieren worden gebruikt:

- Maximale boomdiepte: wanneer de boom het maximale aantal knooppunten bereikt, stopt de uitvoering daar.

- Minimale knooppuntrecords: het kan worden gedefinieerd als een minimum aan patronen dat een knooppunt vereist. Dan kunnen we stoppen met het toevoegen van terminalknooppunten en krijgen we die minimale knooppuntrecords.

2. Recursieve splitsing

Als het knooppunt eenmaal is gemaakt, kunnen we recursief een kindknooppunt maken door de gegevensset te splitsen en dezelfde functie meerdere keren aan te roepen.

Voorspelling

Nadat een boom is gebouwd, wordt de voorspelling gedaan met behulp van een recursieve functie. Hetzelfde voorspellingsproces wordt opnieuw gevolgd met linker of rechter onderliggende knooppunten enzovoort.

Voor- en nadelen van beslissingsboom

Hieronder worden enkele voor- en nadelen gegeven:

voordelen

De beslissingsboom heeft enkele voordelen in Machine Learning als volgt:

- Alomvattend: het houdt rekening met elke mogelijke uitkomst van een beslissing en traceert elk knooppunt dienovereenkomstig.

- Specifiek: beslissingsbomen kennen een specifieke waarde toe aan elk probleem, elke beslissing en elke uitkomst (en). Het vermindert onzekerheid en dubbelzinnigheid en verhoogt ook de duidelijkheid.

- Eenvoud: Decision Tree is een van de gemakkelijkere en betrouwbare algoritmen omdat het geen complexe formules of gegevensstructuren heeft. Alleen eenvoudige statistieken en wiskunde zijn vereist voor de berekening.

- Veelzijdig: beslissingsbomen kunnen handmatig worden gebouwd met behulp van wiskunde en ook worden gebruikt met andere computerprogramma's.

nadelen

De beslissingsboom heeft enkele nadelen in Machine Learning als volgt:

- Beslisbomen zijn minder geschikt voor schatting en financiële taken waarbij we een geschikte waarde (n) nodig hebben.

- Het is een foutgevoelig classificatie-algoritme in vergelijking met andere berekeningsalgoritmen.

- Het is rekenkundig duur. Bij elk knooppunt moet de kandidaatsplitsing worden gesorteerd voordat het beste wordt bepaald. Er zijn andere alternatieven die veel bedrijfsentiteiten volgen voor financiële taken, omdat de beslisboom te duur is voor evaluatie.

- Tijdens het werken met continue variabelen is Decision Tree niet geschikt als de beste oplossing omdat het de neiging heeft informatie te verliezen tijdens het categoriseren van variabelen.

- Het is soms onstabiel omdat kleine variaties in de gegevensset kunnen leiden tot de vorming van een nieuwe boom.

Conclusie - beslissingsboom in machinaal leren

Als een van de belangrijkste en bewaakte algoritmen speelt Decision Tree een cruciale rol in de analyse van beslissingen in het echte leven. Als een voorspellend model wordt het op veel gebieden gebruikt voor zijn gesplitste aanpak die helpt bij het identificeren van oplossingen op basis van verschillende omstandigheden door middel van classificatie of regressiemethode.

Aanbevolen artikelen

Dit is een handleiding voor de beslissingsboom in machinaal leren. Hier bespreken we de introductie, soorten beslissingsboom in machinaal leren, gesplitste creatie en het bouwen van een boom. U kunt ook onze andere voorgestelde artikelen doornemen voor meer informatie–

- Python-gegevenstypen

- Tableau gegevenssets

- Cassandra-gegevensmodellering

- Beslissingstabel testen

- Top 8 fasen van levenscyclus van machine learning