Verschil tussen Hadoop en SQL

De enorme gegevens die elke seconde worden gegenereerd via sociale media zoals Facebook, Twitter en Instagram, hebben de weg vrijgemaakt voor de ontwikkeling van het Hadoop / Big Data-ecosysteem. De term "3V" die verwijst naar Volume, Velocity en Veracity definieert het belang van Hadoop om de streaminggegevens te verwerken. Tegenwoordig worden gegevens gegenereerd uit meerdere bronnen die moeten worden geïntegreerd voor verschillende doeleinden, zoals rapportage, gegevensanalyse en onderzoek en voor gecentraliseerde opslag van gegevens. Wanneer we dit doen, doen zich tal van problemen voor met traditionele benaderingen zoals ruimte, toegang, integriteit, structuur en bandbreedte. Om al deze problemen aan te pakken, biedt Hadoop een raamwerk dat het mogelijk maakt om de gegevens van enorme omvang te verwerken, gemakkelijke toegang, hoge beschikbaarheid te bieden en gegevens dynamisch te laden. Het heeft een Distributed File System framework (HDFS) voor de opslag van gegevens en een ingebouwde queryprocessor genaamd "Map Reduce" voor de analyse en verwerking van gegevens die zijn opgeslagen in HDFS.

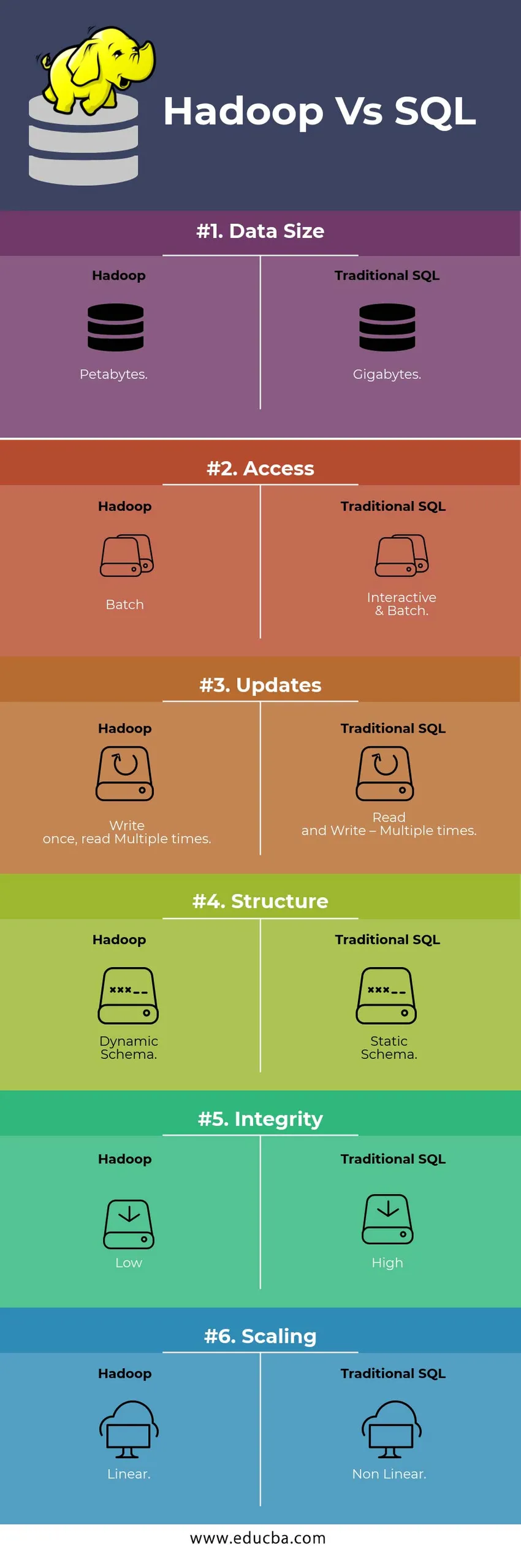

HEAD TO HEAD Vergelijking tussen Hadoop versus SQL

Hieronder staat het top 6-verschil tussen Hadoop versus SQL

Belangrijkste verschillen tussen Hadoop versus SQL

Hieronder is het verschil tussen Hadoop en SQL als volgt

- Schema op WRITE versus LEES

Over het algemeen in een traditionele database, tijdens het laden / migreren van gegevens van de ene naar de andere database, volgt het schema op schrijfbenadering. Dit maakt het laden van gegevens opgewonden / afgebroken en resulteert in afwijzing van records vanwege een verschil in de structuur van de bron- en doeltabellen, terwijl in Hadoop-systeem alle gegevens worden opgeslagen in HDFS en gegevens worden gecentraliseerd.

Hadoop-raamwerk wordt voornamelijk gebruikt voor Data Analytics-proces. Aldus ondersteunt het alle drie gegevenscategorieën, namelijk gestructureerde, semi-gestructureerde en ongestructureerde gegevens en maakt het Schema bij het lezen mogelijk.

- Gestructureerde gegevens hebben een bepaald formaat. g .: XML-bestand.

- Semi-structuurgegevens zijn losser; Misschien heeft het geen schema. g .: Spreadsheet

- Ongestructureerde gegevens hebben geen specifieke structuur of schema. Bijv .: gewone tekst of afbeelding.

Hadoop werkt efficiënt met ongestructureerde gegevens omdat het de gegevens tijdens de verwerkingstijd kan interpreteren.

| Nadering | Voordeel | Voordeel |

| Schema op schrijven | · Vooraf gedefinieerde structuren

· Sneller lezen. Bijv .: traditionele RDBMS. | Trage gegevensbelasting

Hoge latentie |

| Schema op lezen | · Dynamische structuur

· Snel schrijven en lezen. Bijvoorbeeld: Hadoop | Snelle gegevensbelasting

Lage latentie |

Tabel : Schema op WRITE VS Schema op LEES.

- SCHAALBAARHEID & KOSTEN

Hadoop Framework is ontworpen om een grote hoeveelheid gegevens te verwerken. Wanneer de grootte van gegevens toeneemt, kan een aantal extra bronnen, zoals dataknooppunt, zeer eenvoudig aan het cluster worden toegevoegd dan de traditionele benadering van statische geheugentoewijzing. Tijd en budget is relatief zeer minder voor de uitvoering ervan en Hadoop biedt ook gegevenslocatie waar de gegevens beschikbaar worden gesteld in het knooppunt dat de taak heeft uitgevoerd.

- STORING TOLERANTIE

In de traditionele RDBMS, wanneer gegevens verloren gaan als gevolg van corruptie of een netwerkprobleem, kost het meer tijd, kosten en middelen om de verloren gegevens terug te krijgen. Maar Hadoop heeft een mechanisme waarbij de gegevens minimaal drie niveaus van replicatiefactor hebben voor de gegevens die zijn opgeslagen in HDFS. Als een van de dataknooppunten die gegevens bevatten mislukt, kunnen gegevens eenvoudig worden opgehaald uit andere dataknooppunten met een hoge beschikbaarheid van gegevens. Daarom zijn de gegevens direct beschikbaar voor de gebruiker, ongeacht eventuele fouten.

- FUNCTIONELE PROGRAMMERING

Hadoop ondersteunt het schrijven van functioneel programmeren in talen zoals Java, Scala en Python. Voor elke toepassing die extra functionaliteit vereist, kan worden geïmplementeerd door UDF –User Defined Functions in de HDFS te registreren. In RDBMS is er geen mogelijkheid om UDF te schrijven en dit verhoogt de complexiteit van het schrijven van SQL. Bovendien zijn de gegevens die zijn opgeslagen in HDFS toegankelijk voor alle ecosystemen van Hadoop zoals Hive, Pig, Sqoop en HBase. Dus als de UDF is geschreven, kan deze door een van de bovengenoemde toepassingen worden gebruikt. Het verhoogt de prestaties en ondersteuning van het systeem.

- OPTIMIZATION

Hadoop slaat gegevens op in HDFS en Process via Map Reduce met enorme optimalisatietechnieken. De meest populaire technieken die worden gebruikt voor het verwerken van gegevens, zijn het gebruik van partitionering en bucketing van de opgeslagen gegevens. Partitioneren is een methode om de gegevens in HDFS op te slaan door de gegevens te splitsen op basis van de kolom die wordt genoemd voor partitionering. Wanneer de gegevens in HDFS worden geïnjecteerd of geladen, identificeert het de partitiekolom en worden de gegevens naar de betreffende partitiemap geduwd. Dus de query haalt de resultaatset op door de gegevens rechtstreeks uit de gepartitioneerde map op te halen. Dit vermindert de hele scanscan, verbetert de reactietijd en voorkomt latentie.

Een andere benadering wordt Bucketing van de gegevens genoemd. Hierdoor kan de analist de gegevens eenvoudig over de dataknooppunten verspreiden. Alle knooppunten hebben een gelijk aantal gedistribueerde gegevens. De bucket-kolom is zodanig geselecteerd dat deze het minste aantal kardinaliteit heeft.

Deze benaderingen zijn niet beschikbaar in de traditionele methode van SQL.

- DATA TYPE

In een traditionele benadering is het ondersteunde gegevenstype zeer beperkt. Het ondersteunt alleen gestructureerde gegevens. Het kost dus meer tijd om het gegevensschema zelf op te schonen en op te maken. Maar Hadoop ondersteunt complexe gegevenstypes zoals Array, Struct en Map. Dit stimuleert het gebruik van de verschillende soorten gegevens die moeten worden gebruikt voor het laden van gegevens. Voor Ex: de XML-gegevens kunnen worden geladen door de gegevens te definiëren met XML-elementen die een complex gegevenstype bevatten.

- DATA COMPRESSIE

Er zijn heel minder ingebouwde compressietechnieken beschikbaar voor het traditionele databasesysteem. Maar voor het Hadoop-framework zijn er veel compressietechnieken zoals gzib, bzip2, LZO en snappy. De standaard compressiemodus is LZ4. Zelfs de tabellen kunnen worden gecomprimeerd met behulp van de compressietechnieken zoals Parquet, ORC. Compressietechnieken helpen de tabellen minder ruimte in te nemen, verhogen de doorvoer en snellere uitvoering van zoekopdrachten.

Hadoop versus SQL-vergelijkingstabel

| Kenmerken | Traditionele SQL | Hadoop |

| Gegevensgrootte | gigabytes | petabytes |

| Toegang | Interactief & Batch | Partij |

| updates | Lezen en schrijven - Meerdere keren | Schrijf eenmaal, lees Meerdere keren |

| Structuur | Statisch schema | Dynamisch schema |

| Integriteit | hoog | Laag |

| scaling | Non-Linear | Lineair |

Tabel : vergelijking tussen traditionele Hadoop en SQL Framework.

Conclusie - Hadoop versus SQL

Over het algemeen loopt Hadoop voor op de traditionele SQL in termen van kosten, tijd, prestaties, betrouwbaarheid, ondersteuning en beschikbaarheid van gegevens voor de zeer grote gebruikersgroep. Om de enorme hoeveelheid gegevens die elke dag wordt gegenereerd efficiënt te verwerken, helpt Hadoop-framework bij het tijdig vastleggen, opslaan, verwerken, filteren en uiteindelijk opslaan op een gecentraliseerde plaats.

Aanbevolen artikel

- Hadoop vs Hive - Ontdek de beste verschillen

- Leer het 10 nuttige verschil tussen Hadoop en roodverschuiving

- HADOOP versus RDBMS | Ken de 12 nuttige verschillen

- Apache Hadoop vs Apache Spark | Top 10 vergelijkingen die u moet weten!

- Hadoop vs Spark: Functies