Inleiding tot eenvoudige lineaire regressie

Uit woordenboek : een terugkeer naar een vroegere of minder ontwikkelde staat.

In Statistiek: een maat voor de relatie tussen de gemiddelde waarde van een variabele en overeenkomstige waarden van de andere variabelen.

De regressie, waarin de relatie tussen de ingangsvariabele (onafhankelijke variabele) en doelvariabele (afhankelijke variabele) als lineair wordt beschouwd, wordt lineaire regressie genoemd. Eenvoudige lineaire regressie is een type lineaire regressie waarbij we slechts één onafhankelijke variabele hebben om de afhankelijke variabele te voorspellen. Simple Linear Regression is een van de machine learning-algoritmen. Eenvoudige lineaire regressie behoort tot de familie van Supervised Learning. Regressie wordt gebruikt voor het voorspellen van continue waarden.

Model van eenvoudige lineaire regressie

Laten we het simpel maken. Hoe het allemaal begon?

Het begon allemaal in 1800 met Francis Galton. Hij bestudeerde de relatie in lengte tussen vaders en hun zonen. Hij observeerde een patroon: de lengte van de zoon zou even lang zijn als de lengte van zijn vader of de lengte van de zoon zal de neiging hebben dichter bij de gemiddelde gemiddelde lengte van alle mensen te liggen. Dit fenomeen is niets anders dan regressie.

Shaq O'Neal is bijvoorbeeld een zeer beroemde NBA-speler en is 2, 16 meter lang. Zijn zonen Shaqir en Shareef O'neal zijn respectievelijk 1, 96 meter en 2, 06 meter lang. De gemiddelde populatiehoogte is 1, 76 meter. De lengte van de zoon neemt af (drijft af naar) de gemiddelde hoogte.

Hoe doen we regressie?

Een regressie berekenen met slechts twee gegevenspunten:

Het enige wat we willen doen om de beste regressie te vinden, is een lijn trekken die zo dicht mogelijk bij elke stip ligt. In het geval van twee gegevenspunten is het eenvoudig om een lijn te trekken, voeg ze gewoon samen.

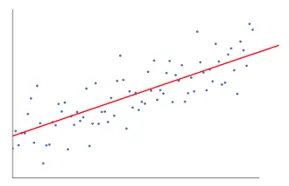

Als we nu een aantal gegevenspunten hebben, hoe teken je dan de lijn die zo dicht mogelijk bij elk gegevenspunt ligt.

In dit geval is ons doel om de verticale afstand tussen de lijn en alle gegevenspunten te minimaliseren. Op deze manier voorspellen we de beste lijn voor ons lineaire regressiemodel.

Wat doet eenvoudige lineaire regressie?

Hieronder vindt u de gedetailleerde uitleg van Simple Linear Regression:

- Het tekent heel veel mogelijke lijnen en voert vervolgens deze analyse uit.

- Som van kwadraatfouten.

- Som van absolute fouten.

- minst vierkante methode … enz

- Voor onze analyse zullen we de minst vierkante methode gebruiken.

- We maken een verschil van alle punten en berekenen het kwadraat van de som van alle punten. Welke regel ook het minimumbedrag geeft, is onze beste regel.

Bijvoorbeeld: Door dit te doen kunnen we meerdere mannen en de lengte van hun zoon nemen en dingen doen zoals een man vertellen hoe lang zijn zoon zou kunnen zijn. voordat hij zelfs werd geboren.

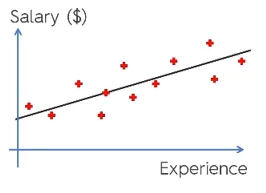

Google afbeelding

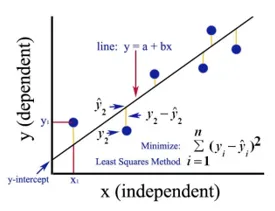

De bovenstaande figuur toont een eenvoudige lineaire regressie. De lijn vertegenwoordigt de regressielijn. Gegeven door: y = a + b * x

Waar y de afhankelijke variabele (DV) is: bijvoorbeeld hoe het salaris van een persoon verandert, afhankelijk van het aantal jaren ervaring dat de werknemer heeft. Dus hier is het salaris van een werknemer of persoon uw afhankelijke variabele.

De afhankelijke variabele is onze doelvariabele, degene die we willen voorspellen met behulp van lineaire regressie.

x is onze onafhankelijke variabele (IV): de afhankelijke variabele is de oorzaak van de veranderonafhankelijke variabele. In het bovenstaande voorbeeld is het aantal jaren ervaring onze afhankelijke variabele, omdat het aantal jaren ervaring de verandering in het salaris van de werknemer veroorzaakt.

- b is de coëfficiëntvariabele voor onze onafhankelijke variabele x. Deze coëfficiënt speelt een cruciale rol. Het zegt hoe een eenheidsverandering in x (IV) y (DV) zal beïnvloeden. Het wordt ook de evenredige coëfficiënt genoemd. In termen van wiskunde is het aan jou de helling van de lijn of je kunt steil van de lijn zeggen.

- In ons voorbeeld, als helling (b) minder is, wat betekent dat het aantal jaren minder salarisstijging zal opleveren, als de helling (b) meer is, zal een hoge salarisstijging met een toename van het aantal Jarenlange ervaring.

- a is een constante waarde. Het wordt ook wel onderscheppen genoemd, dat is waar de lijn de y-as of DV-as snijdt. Op een andere manier kunnen we zeggen dat wanneer een werknemer nul jaar ervaring heeft (x), het salaris (y) voor die werknemer constant zal zijn (a).

Hoe werkt Least Square?

Hieronder staan de punten voor het minste vierkante werk:

- Het trekt een willekeurige lijn volgens de gegevenstrends.

- Het neemt gegevenspunten en tekent verticale lijnen. Het beschouwt verticale afstand als een parameter.

- Deze verticale lijnen snijden de regressielijn en geven het overeenkomstige punt voor gegevenspunten.

- Het zal dan het verticale verschil vinden tussen elk gegevenspunt en het bijbehorende gegevenspunt op de regressielijn.

- Het berekent de fout die het kwadraat van het verschil is.

- Vervolgens wordt de som van fouten berekend.

- Vervolgens zal het een lijn trekken en de bovenstaande procedure opnieuw herhalen.

- Het trekt een aantal lijnen op deze manier en de lijn die de minste fout geeft, wordt gekozen als de beste lijn.

- Deze beste lijn is onze eenvoudige lineaire regressielijn.

Toepassing van eenvoudige lineaire regressie

Regressieanalyse wordt uitgevoerd om de continue variabele te voorspellen. De regressieanalyse heeft een breed scala aan toepassingen. Enkele voorbeelden zijn:

- Voorspellende analyse

- Effectiviteit van marketing,

- prijzen van een aanbieding

- promotie voorspelling voor een product.

Hier gaan we één toepassing van lineaire regressie voor voorspellende analyses bespreken. We zullen modelleren met behulp van python.

De stappen die we gaan volgen om ons model te bouwen zijn als volgt:

- We zullen de bibliotheken en datasets wel importeren.

- We zullen de gegevens pre-verwerken.

- We zullen de gegevens verdelen in de testset en de trainingsset.

- We zullen een model maken dat zal proberen de doelvariabele te voorspellen op basis van onze trainingsset

- We zullen de doelvariabele voor de testset voorspellen.

- We zullen de door het model voorspelde resultaten analyseren

Voor onze analyse gaan we een salarisgegevensset gebruiken met de gegevens van 30 werknemers.

# Importeren van de bibliotheken

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Importeren van de dataset (voorbeeld van data wordt getoond in tabel)

dataset = pd.read_csv('Salary_Data.csv')

| Jarenlange ervaring | Salaris |

| 1.5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55.749 |

# Pre-verwerking van de dataset, hier zullen we de dataset verdelen in de afhankelijke variabele en onafhankelijke variabele. x als onafhankelijk en y als afhankelijk of doelvariabele

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Splitsen van de dataset in de Trainingsset en Testset:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Hier toont testgrootte 1/3 dat van de totale gegevens 2/3 deel is voor het trainen van het model en rust 1/3 wordt gebruikt voor het testen van het model.

# Laten we ons Simple Linear Regression-model aan de trainingsset aanpassen

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Lineair regressiemodel wordt nu getraind. Dit model zal worden gebruikt voor het voorspellen van de afhankelijke variabele.

# De resultaten van de testset voorspellen

y_pred = regressor.predict(X_test)

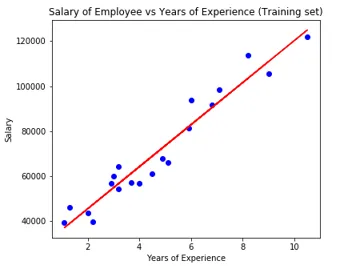

# Visualisatie van de testsetresultaten

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Parameter van het model

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Dus de waarde van de interceptor (a) is 26816. Wat suggereert dat een frisser (nul-ervaring) ongeveer 26816 als salaris zou krijgen.

De coëfficiënt voor ons model kwam uit op 9345.94. Het suggereert dat als alle andere parameters constant worden gehouden, de verandering in een eenheid van de onafhankelijke variabele (jaren van exp.) Een verandering van 9345 eenheden in salaris zal opleveren.

Regressie Evaluatie Metrics

Er zijn in principe 3 belangrijke evaluatiemethoden beschikbaar voor regressieanalyse:

- Mean Absolute Error (MAE): het toont het gemiddelde van de absolute fouten, wat het verschil is tussen voorspelde en werkelijke.

- Mean Squared Error (MSE): het toont de gemiddelde waarde van kwadraatfouten.

- Root Mean Squared Error (RMSE): het toont de vierkantswortel van het gemiddelde van de kwadratenfouten.

We kunnen bovenstaande methoden met elkaar vergelijken:

- MAE: Het toont de gemiddelde fout en de gemakkelijkste van alle drie methoden.

- MSE: deze is populairder dan MAE omdat deze de grotere fouten verbetert, wat resulteert in meer inzichten.

- RMSE: Deze is beter dan MSE omdat we de fout kunnen interpreteren in termen van y.

Deze 3 zijn niets anders dan de verliesfuncties.

# Evaluatie van het model

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Conclusie

Lineaire regressieanalyse is een krachtig hulpmiddel voor algoritmen voor machine learning, die wordt gebruikt voor het voorspellen van continue variabelen zoals salaris, omzet, prestaties, enz. Lineaire regressie houdt rekening met de lineaire relatie tussen onafhankelijke en afhankelijke variabelen. Eenvoudige lineaire regressie heeft slechts één onafhankelijke variabele op basis waarvan het model de doelvariabele voorspelt. We hebben het model en de toepassing van lineaire regressie besproken met een voorbeeld van voorspellende analyse om het salaris van werknemers te voorspellen.

Aanbevolen artikelen

Dit is een gids voor Simple Linear Regression. Hier bespreken we het model en de toepassing van lineaire regressie, met behulp van een voorbeeld van voorspellende analyse voor het voorspellen van de salarissen van werknemers. U kunt ook onze andere gerelateerde artikelen doornemen voor meer informatie-

- Lineaire regressieanalyse

- Lineaire regressie in R

- Lineaire regressiemodellering

- Hulpmiddelen voor het testen van regressie

- Matplotlib In Python | Top 14 percelen in Matplotlib

- Woordenboek in Python | Methoden en voorbeelden

- Voorbeelden van vierkantswortel in PHP

- Lineaire regressie versus logistieke regressie | Topverschillen