Verschil tussen Hadoop en Elasticsearch

Hadoop is een raamwerk dat helpt bij het verwerken van de omvangrijke gegevens in een fractie van seconden, waar traditionele manieren niet slagen. Er is ondersteuning nodig van meerdere machines om het proces op een gedistribueerde manier parallel uit te voeren. Elasticsearch werkt als een sandwich tussen Logstash en Kibana. Waar Logstash verantwoordelijk is voor het ophalen van de gegevens uit elke gegevensbron, analyseert elastisch zoeken de gegevens en ten slotte geeft kibana de bruikbare inzichten daaruit. Deze oplossing maakt applicaties krachtiger om te werken in complexe zoekvereisten of eisen.

Laten we nu het onderwerp in detail bekijken:

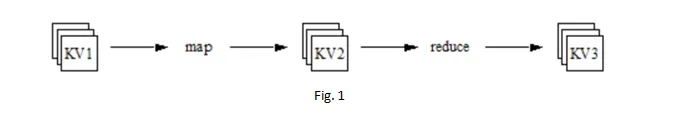

De unieke manier van gegevensbeheer (speciaal ontworpen voor Big data), inclusief een end-to-end proces van opslaan, verwerken en analyseren. Deze unieke manier wordt MapReduce genoemd. Ontwikkelaars schrijven de programma's in het MapReduce-framework om de uitgebreide gegevens parallel te laten lopen over gedistribueerde processors.

De vraag rijst dan, nadat gegevens worden verspreid voor verwerking in verschillende machines, hoe output op een vergelijkbare manier wordt verzameld?

Het antwoord is, MapReduce genereert een unieke sleutel die wordt toegevoegd met gedistribueerde gegevens op verschillende machines. MapReduce houdt de verwerking van gegevens bij. En als het eenmaal is gedaan, wordt die unieke sleutel gebruikt om alle verwerkte gegevens samen te voegen. Dit geeft het gevoel van al het werk dat op één machine is gedaan.

Schaalbaarheid en betrouwbaarheid worden perfect geregeld in MapReduce of Hadoop. Hieronder staan enkele functionaliteiten van MapReduce:

- De kaart verkleint vervolgens: om een taak uit te voeren, wordt deze opgedeeld in afzonderlijke delen die taak worden genoemd. Mapper-functie wordt altijd eerst uitgevoerd voor alle taken, daarna wordt alleen de functie voor verkleinen weergegeven. Het hele proces wordt alleen voltooid genoemd als de functie verkleinen zijn werk voor alle gedistribueerde taken voltooit.

- Fouttolerant: Neem een scenario, wanneer een knooppunt uitvalt tijdens het verwerken van de taak? De hartslag van dat knooppunt reikt niet tot de motor van MapReduce of zeg Meester-knooppunt. In dat geval wijst de Master-knooppunt die taak toe aan een ander knooppunt om de taak te voltooien. Bovendien worden de onverwerkte en verwerkte gegevens bewaard in HDFS (Hadoop Distributed File System), dat een opslaglaag van Hadoop is met de standaard replicatiefactor van 3. Dit betekent dat als een knoop naar beneden gaat er nog twee knooppunten in leven zijn met dezelfde gegevens.

- Flexibiliteit: u kunt elk type gegevens opslaan: gestructureerd, semi-gestructureerd of ongestructureerd.

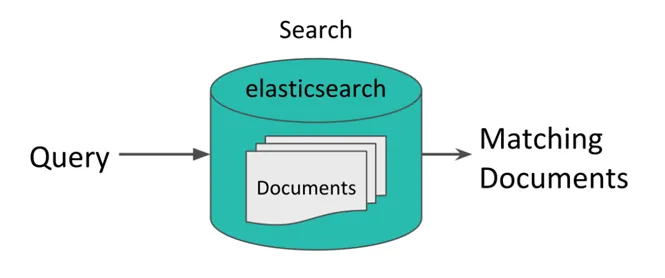

- Synchronisatie: Synchronisatie is een ingebouwde eigenschap van Hadoop. Dit zorgt ervoor dat verkleinen alleen start als alle mapper-functie met zijn taak is voltooid. "Shuffle" en "Sort" is het mechanisme dat de uitvoer van de taak soepeler maakt. Elastisch zoeken is een op JSON gebaseerd eenvoudig, maar krachtig analytisch hulpmiddel voor documentindexering en krachtig zoeken in volledige tekst.

Figuur 2

In ELK zijn alle componenten open source. ELK neemt veel momentum in IT-omgeving voor loganalyse, webanalyse, business intelligence, compliance-analyse enz. ELK is geschikt voor bedrijven waar ad-hocverzoeken komen en gegevens snel moeten worden geanalyseerd en gevisualiseerd.

ELK is een geweldig hulpmiddel voor technische startups die het zich niet kunnen veroorloven om een licentie te kopen voor loganalyseproducten zoals Splunk. Bovendien zijn open source-producten altijd de focus geweest in de IT-industrie.

Head-to-Head-vergelijkingen tussen Hadoop en Elasticsearch (Infographics)

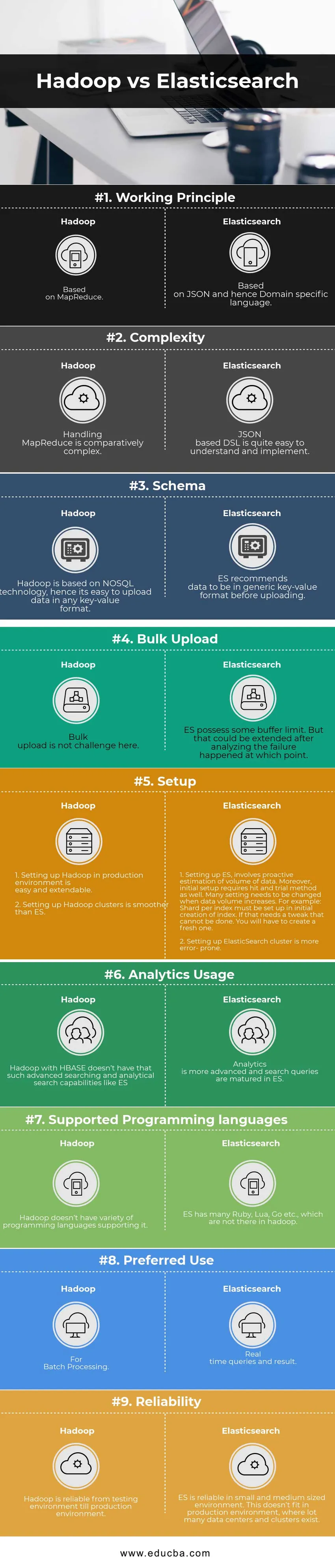

Hieronder vindt u de top 9 vergelijkingen tussen Hadoop en Elasticsearch

Belangrijkste verschil tussen Hadoop en Elasticsearch

Belangrijkste verschil tussen Hadoop en Elasticsearch

Hieronder staan de lijst met punten, beschrijf de belangrijkste verschillen tussen Hadoop en Elasticsearch:

- Hadoop heeft een bestandssysteem gedistribueerd dat is ontworpen voor parallelle gegevensverwerking, terwijl ElasticSearch de zoekmachine is.

- Hadoop biedt veel meer flexibiliteit met een verscheidenheid aan tools in vergelijking met ES.

- Hadoop kan veel gegevens opslaan, terwijl ES dat niet kan.

- Hadoop kan omgaan met uitgebreide verwerking en complexe logica, waarbij ES slechts beperkte verwerking en logische basisaggregatie aankan.

Hadoop vs Elasticsearch Vergelijkingstabel

| Vergelijkingsbasis | Hadoop | Elasticsearch |

| Werkend principe | Gebaseerd op MapReduce | Gebaseerd op JSON en dus domeinspecifieke taal |

| ingewikkeldheid | Omgaan met MapReduce is relatief complex | Op JSON gebaseerde DSL is vrij eenvoudig te begrijpen en te implementeren |

| Schema | Hadoop is gebaseerd op NoSQL-technologie, vandaar dat het gemakkelijk is om gegevens in elk sleutel / waarde-formaat te uploaden | ES beveelt aan dat de gegevens in generieke sleutel / waarde-indeling zijn voordat ze worden geüpload |

| Massa upload | Bulkupload is hier geen uitdaging | ES beschikt over een bufferlimiet. Maar dat kon worden uitgebreid nadat de analyse op dat moment plaatsvond. |

| Opstelling | 1. Hadoop instellen in een productieomgeving is eenvoudig en uitbreidbaar.

2. Het opzetten van Hadoop-clusters is soepeler dan ES. | 1. ES instellen omvat een proactieve schatting van het gegevensvolume. Bovendien vereist de initiële installatie ook een hit- en proefmethode. Veel instellingen moeten worden gewijzigd wanneer het gegevensvolume toeneemt. Scherf per index moet bijvoorbeeld worden ingesteld bij het maken van een index. Als dat een tweak nodig heeft, kan dat niet. U moet een nieuwe maken.

2.ElasticalSearch-cluster instellen is meer foutgevoelig. |

| Analytics-gebruik | Hadoop met HBase beschikt niet over zulke geavanceerde zoek- en analytische zoekmogelijkheden zoals ES | Analytics is geavanceerder en zoekopdrachten worden gerijpt in ES |

| Ondersteunde programmeertalen | Hadoop heeft geen verschillende programmeertalen die dit ondersteunen. | ES heeft veel Ruby, Lua, Go etc., die er niet zijn in Hadoop |

| Gewenst gebruik | Voor batchverwerking | Realtime vragen en resultaten |

| Betrouwbaarheid | Hadoop is betrouwbaar van testomgeving tot productieomgeving | ES is betrouwbaar in een kleine en middelgrote omgeving. Dit past niet in een productieomgeving, waar veel datacenters en clusters bestaan. |

Conclusie - Hadoop vs Elasticsearch

Uiteindelijk hangt het eigenlijk af van het datatype, volume en use case, waar men aan werkt. Als eenvoudig zoeken en webanalyse de focus is, is Elasticsearch beter om mee te werken. Terwijl als er een grote vraag is naar schaalvergroting, een hoeveelheid gegevens en compatibiliteit met tools van derden, de Hadoop-instantie hier het antwoord op is. De integratie van Hadoop met ES opent echter een nieuwe wereld voor zware en grote toepassingen. Het benutten van de volledige kracht van Hadoop en Elasticsearch kan een goed platform bieden om maximale waarde uit big data te verrijken.

Aanbevolen artikelen:

Dit is een leidraad geweest voor Hadoop versus Elasticsearch, hun betekenis, vergelijking van persoon tot persoon, belangrijkste verschillen, vergelijkingstabel en conclusie. U kunt ook de volgende artikelen bekijken voor meer informatie -

- How to Crack the Hadoop developer interview Vragen

- Hadoop vs Apache Spark

- HADOOP versus RDBMS | Ken de 12 nuttige verschillen

- Hoe het Hadoop-ontwikkelaarsinterview te kraken?

- Waarom innovatie het meest kritieke aspect van big data?

- Beste gids over Hadoop vs Spark