Inleiding tot Hadoop Framework

Voordat we diep ingaan op het technische kader van Hadoop, beginnen we met een eenvoudig voorbeeld.

Er is een boerderij die tomaten oogst en ze opslaat in een enkele opslagruimte, nu met de toenemende vraag naar groenten, begon de boerderij aardappelen en wortelen te oogsten - met een toenemende vraag was er een tekort aan boeren, dus namen ze meer boeren in dienst. Na enige tijd beseften ze dat er een tekort was in de opslagruimte - dus verdeelden ze de groenten in verschillende opslagruimtes. Als het gaat om het ophalen van de gegevens, werken ze allemaal parallel met hun eigen opslagruimte.

Dus hoe dit verhaal is gerelateerd aan big data?

Eerder hadden we beperkte gegevens, met de beperkte processor en één opslageenheid. Maar toen nam het genereren van gegevens toe, wat leidde tot een hoog volume en verschillende variëteiten - gestructureerd, semi-gestructureerd en ongestructureerd, dus de oplossing was om gedistribueerde opslag voor elke processor te gebruiken, waardoor gemakkelijke toegang tot gegevens kon worden verkregen.

Dus nu kunnen we de groenten vervangen als verschillende soorten gegevens en opslagplaatsen als de gedistribueerde plaatsen om de gegevens op te slaan en verschillende werknemers die elke processor zijn.

Dus big data is de uitdaging en Hadoop speelt de rol van de oplossing.

Hadoop

1. Oplossing voor GROTE GEGEVENS: omdat het te maken heeft met complexiteiten van grote hoeveelheden, snelheid en verscheidenheid aan gegevens.

2. Set van het open-sourceproject.

3. Slaat een grote hoeveelheid gegevens betrouwbaar op en maakt enorme gedistribueerde berekeningen mogelijk.

4. De belangrijkste kenmerken van Hadoop zijn redundantie en betrouwbaarheid (absoluut geen gegevensverlies).

5. Richt zich primair op batchverwerking.

6. Werkt op basishardware - u hoeft geen speciale dure hardware te kopen.

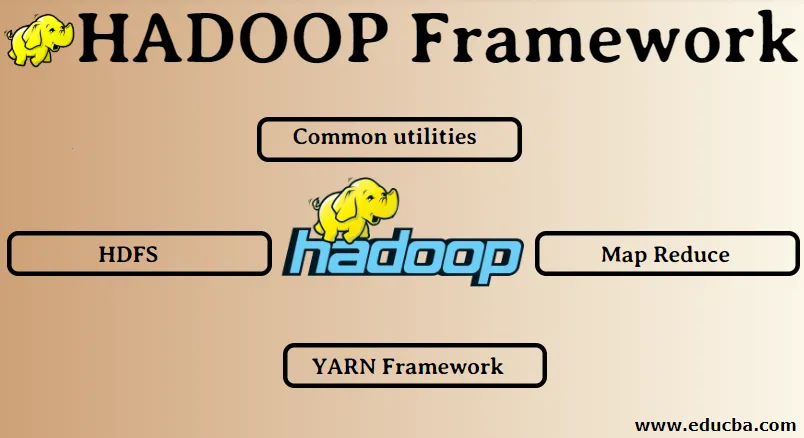

Hadoop Framework:

1. Gemeenschappelijke hulpprogramma's

2. HDFS

3. Kaart verkleinen

4. GAREN Framework

1. Gemeenschappelijke hulpprogramma's:

Wordt ook de gemeenschappelijke Hadoop genoemd. Dit zijn niets anders dan de JAVA-bibliotheken, bestanden, scripts en hulpprogramma's die daadwerkelijk door de andere Hadoop-componenten moeten worden uitgevoerd.

2. HDFS: Hadoop gedistribueerd bestandssysteem

Waarom had Hadoop ervoor gekozen om een gedistribueerd bestandssysteem op te nemen?

Laten we dit met een voorbeeld begrijpen: we moeten 1 TB aan gegevens lezen en we hebben één machine met 4 I / O-kanalen waarbij elk kanaal 100 MB / s heeft, het duurde 45 minuten om de volledige gegevens te lezen. Nu wordt dezelfde hoeveelheid gegevens gelezen door 10 machines met elk 4 I / O-kanalen, elk kanaal met 100 MB / s. Raad eens hoeveel tijd het kostte om de gegevens te lezen? 4, 3 minuten. HDFS lost het probleem van het opslaan van big data op. De twee hoofdcomponenten van HDFS zijn NAME NODE en DATA NODE. Naamknooppunt is de master, we kunnen ook een secundaire naamknoop hebben in het geval dat de primaire naamknoop stopt met werken, zal de secundaire naamknoop fungeren als een back-up. Het naamknooppunt onderhoudt en beheert in feite de gegevensknooppunten door metagegevens op te slaan. Het dataknooppunt is de slave, wat in feite de goedkope hardware is. We kunnen meerdere dataknooppunten hebben. Het gegevensknooppunt slaat de feitelijke gegevens op. Dit gegevensknooppunt ondersteunt de replicatiefactor, stel dat als een gegevensknoop uitvalt, de gegevens toegankelijk zijn voor het andere gerepliceerde gegevensknooppunt, waardoor de toegankelijkheid van gegevens wordt verbeterd en gegevensverlies wordt voorkomen.

3. Kaart verkleinen:

Het lost het probleem op van het verwerken van big data. Laten we het concept van kaartreductie begrijpen door dit probleem uit de echte wereld op te lossen. ABC-bedrijf wil zijn totale omzet berekenen, stadsgewijs. Nu werkt het hashtabelconcept niet omdat de gegevens in terabytes zijn, dus zullen we het Map-Reduce-concept gebruiken.

Er zijn twee fasen: a) MAP. b) VERMINDEREN

a) Kaart : Eerst splitsen we de gegevens in kleinere brokken, mappers genaamd, op basis van het sleutel / waarde-paar. Dus hier is de sleutel de plaatsnaam en de waarde de totale verkoop. Elke mapper krijgt de gegevens van elke maand die een plaatsnaam en bijbehorende verkoop geeft.

b) Verkleinen: het zal deze stapels met gegevens krijgen en elk verloopstuk is verantwoordelijk voor de steden Noord / West / Oost / Zuid. Het werk van het verloopstuk is dus het verzamelen van deze kleine stukjes en converteren naar grotere hoeveelheden (door ze op te tellen) voor een bepaalde stad.

4.YARN Framework: nog een andere onderhandelaar voor hulpbronnen.

De eerste versie van Hadoop had slechts twee componenten: Map Reduce en HDFS. Later werd vastgesteld dat Map Reduce veel big data-problemen niet kon oplossen. Het idee was om de verantwoordelijkheden voor resource management en taakplanning weg te nemen van de oude engine voor het verminderen van kaarten en deze aan een nieuwe component te geven. Dus zo kwam YARN in beeld. Het is de middelste laag tussen HDFS en Map Reduce die verantwoordelijk is voor het beheer van clusterbronnen.

Het moet twee belangrijke rollen vervullen: a) Taakplanning. b) Beheer van middelen

a) Taakplanning: wanneer een grote hoeveelheid gegevens wordt verwerkt, moet deze worden verdeeld en opgesplitst in verschillende taken / taken. Nu beslist de JS welke taak de hoogste prioriteit moet krijgen, het tijdsinterval tussen twee taken, afhankelijkheid tussen de taken, controleert of er geen overlapping is tussen de lopende taken.

b) Resource Management: voor het verwerken van de gegevens en voor het opslaan van de gegevens hebben we toch bronnen nodig? Dus de resource manager biedt, beheert en onderhoudt de bronnen om de gegevens op te slaan en te verwerken.

Dus nu zijn we duidelijk over het concept van Hadoop en hoe het de uitdagingen van de GROTE GEGEVENS oplost !!!

Aanbevolen artikelen

Dit is een handleiding voor Hadoop Framework geweest. Hier hebben we ook de 4 belangrijkste Hadoop-frameworks besproken. U kunt ook onze andere voorgestelde artikelen doornemen voor meer informatie -

- Hadoop-database

- Hadoop Ecosysteem

- Gebruik van Hadoop

- Hadoop Administrator Jobs

- Hadoop-beheerder | Vaardigheden & carrièrepad