Wat is Apache Hadoop Ecosystem?

Apache Hadoop Ecosystem is een framework of een open-source dataplatform dat is toegewezen om de enorme gegevensverzamelingen ongestructureerd op te slaan en te onderzoeken. Over de hele wereld wordt er een heleboel data voortgestuwd door talloze digitale platforms met de toonaangevende innovatieve technologie van big data. Bovendien was Apache Hadoop de eerste die deze stroom van innovatie kreeg.

Wat bestaat uit Hadoop Data-architectuur / ecosysteem?

Het Hadoop Ecosysteem is geen programmeertaal of een service, het is een framework of platform dat big data-problemen oplost. U kunt het identificeren als een suite die verschillende services omvat, zoals opslaan, innemen, onderhouden en analyseren. Onderzoek vervolgens en krijg een beknopte gedachte over hoe de services exclusief en in samenwerking werken. De Apache Hadoop-architectuur bestaat uit verschillende innovaties en Hadoop-elementen waarmee zelfs de gecompliceerde informatieproblemen effectief kunnen worden opgelost.

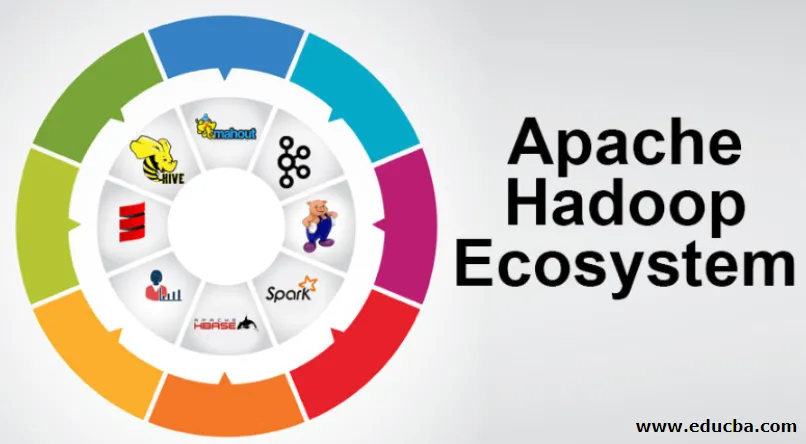

Hierna volgt de afbeelding van elk onderdeel: -

1) Namenode: het stuurt het informatieproces aan

2) Datanode: het stelt de informatie samen in de lokale opslag. Het wordt niet voortdurend aanbevolen om alle informatie op een enkele plek op te slaan, omdat dit verlies van informatie kan veroorzaken in geval van uitval.

3) Taakvolger: zij ontvangen taken toegewezen aan het slaafknooppunt

4) Kaart: er wordt informatie uit een stream gehaald en elke regel wordt verdeeld verdeeld om deze in verschillende velden te verdelen

5) Verminderen: hier worden de via Map verkregen velden verzameld of met elkaar verbonden

Apache Hadoop Ecosystem - stap voor stap

Elk element van het Hadoop-ecosysteem, omdat specifieke aspecten voor de hand liggen. Het uitgebreide perspectief op de Hadoop-structuur biedt opmerkelijke kwaliteit voor Hadoop Distributed File Systems (HDFS), Hadoop YARN, Hadoop MapReduce en Hadoop MapReduce van het ecosysteem van de Hadoop. Hadoop biedt zelfs elke Java-bibliotheek, belangrijke Java-records, reflectie op OS-niveau, voordelen en scripts om Hadoop te bedienen. Hadoop YARN is een methode voor bedrijfsoverzicht en bosresourcebeheer. In de Hadoop-configuratie geeft de HDFS een hoge doorvoer door aan applicatie-informatie en Hadoop MapReduce geeft op YARN gebaseerde parallelle voorbereiding van uitgebreide gegevensassortimenten.

Apache Hadoop Ecosysteem Overzicht

Het is een fundamenteel onderwerp om te begrijpen voordat u begint te werken met het Hadoop Ecosysteem. Hieronder staan de essentiële componenten:

- HDFS: dit is het centrale deel van het Hadoop Ecosysteem en het kan een enorme hoeveelheid ongestructureerde, gestructureerde en semi-gestructureerde informatie opslaan.

- YARN: Het lijkt op de geest van het Hadoop-ecosysteem en alle handelingen worden hier direct uitgevoerd, met inbegrip van activaspreiding, planning van taken en het voorbereiden van acties.

- MapReduce: het is een combinatie van twee processen, beschreven als Map en Reduce en bestaat in essentie uit het voorbereiden van onderdelen die enorme informatieve collecties samenstellen met behulp van parallelle en verspreide algoritmen binnen het Hadoop-ecosysteem.

- Apache Pig: Het is een taal van de procedure, die wordt gebruikt voor parallelle verwerkingstoepassingen om enorme informatieve collecties in Hadoop-toestand te verwerken en deze taal is een optie voor de Java-programmering.

- HBase: het is een open-source en een niet-gekoppelde of NoSQL-database. Het ondersteunt alle informatietypes en kan dus elk informatietype binnen een Hadoop-framework aan.

- Mahout, Spark MLib: Mahout wordt gebruikt voor machine learning en geeft de natuur aan het creëren van machine learning-applicaties.

- Zookeeper: Om met de groepen om te gaan, kan men Zookeeper gebruiken, het wordt anders de heer van de coördinatie genoemd, die betrouwbare, snelle en uitgezochte operationele administraties voor de Hadoop-bossen kan geven.

- Oozie: Apache Oozie werkt met werkplanning en functioneert als alarm- en klokservices binnen het Hadoop Ecosystem.

- Ambari: Het is een onderneming van Apache Software Foundation en kan het Hadoop-ecosysteem geleidelijk flexibel uitvoeren.

Hadoop GAREN:

Denk aan YARN als de geest van je Hadoop-ecosysteem. Het speelt al uw verwerkingen af door activa en planningen toe te wijzen.

Het heeft twee opmerkelijke segmenten die ResourceManager en NodeManager zijn.

- ResourceManager: - Het is opnieuw een belangrijk knooppunt in de operationele divisie. Het krijgt de voorbereidende vragen en geeft vervolgens de vragen door aan respectievelijk NodeManagers, waar de echte afhandeling gebeurt.

- NodeManagers: - Deze worden op elke DataNode geïnstalleerd. Het is verantwoordelijk voor de uitvoering van een opdracht op elke DataNode.

Hoe werkt apache Hadoop?

- Het is bedoeld om op te stijgen van individuele servers naar een enorme hoeveelheid machines, die elk lokale berekeningen en capaciteit bieden. In plaats van afhankelijk te zijn van de apparatuur om hoge toegankelijkheid over te brengen, is de bibliotheek zelf bedoeld om teleurstellingen op de applicatielaag te onderscheiden en af te handelen, waardoor een buitengewoon toegankelijke service wordt geleverd over een aantal pc's, die allemaal tot teleurstellingen kunnen leiden.

- Kijk echter verder, en er zijn aanzienlijk toenemende charme op het werk. Hadoop is volledig modulair, wat inhoudt dat je praktisch elk van zijn segmenten kunt ruilen voor een alternatieve softwaretool. Dat maakt de architectuur fantastisch aanpasbaar, net zo krachtig en effectief.

Apache Hadoop Spark:

- Apache Spark is een systeem voor realtime informatieanalyse in een verspreide computeromgeving. Het implementeert in-memory berekeningen om de snelheid van informatieverwerking op te bouwen.

- Het is sneller voor het verwerken van informatie op grote schaal omdat het gebruik maakt van berekeningen in het geheugen en verschillende verbeteringen. Langs deze lijnen vereist het een hoge verwerkingskracht.

Hoe werkt Apache Pig?

- Apache Pig is een voordelig systeem Yahoo is ontwikkeld om grote informatieposities effectief en soepel te onderzoeken. Het geeft een aantal informatiestroom Pig Latin op het hoogste niveau die verbeterd, uitbreidbaar en eenvoudig te gebruiken is.

- De uitzonderlijke component van Pig-programma's waarin hun samenstelling beschikbaar is voor substantiële parallellisatie, waardoor dit eenvoudig is voor het verzorgen van substantiële informatiecollecties.

Case voor varkensgebruik:

- De privégezondheidsinformatie van een persoon is privé en mag niet aan andere mensen worden bekendgemaakt. Deze gegevens moeten worden verborgen om geheimhouding te bewaren, maar de informatie over medicinale diensten is zo groot dat het herkennen en uitsluiten van individuele informatie over gezondheidszorg essentieel is. Apache Pig kan onder dergelijke omstandigheden worden gebruikt om gezondheidsgegevens te de-herkennen.

Conclusie:

- Het is geschetst om op te stijgen van slechts één server naar een enorme hoeveelheid machines, die allemaal rekenkracht en capaciteit in de buurt bieden. Kijk echter verder en er is steeds meer betovering op het werk.

- Hadoop is volledig modulair, wat inhoudt dat je praktisch elk onderdeel kunt inruilen voor een alternatieve softwaretool. Dat maakt de structuur fantastisch aanpasbaar, net zo krachtig en effectief.

Aanbevolen artikelen

Dit is een gids geweest voor Apache Hadoop Ecosystem. Hier hebben we besproken wat is Apache Hadoop Ecosystem? overzicht van Hadoop-architectuur en de werking van het Hadoop-ecosysteem. U kunt ook onze andere voorgestelde artikelen doornemen voor meer informatie -

- Hadoop ecosysteemcomponenten

- Hoe Apache te installeren

- Apache Spark Training

- Carrière in Hadoop